blkmov指令使用例子,ORB-SLAM2代碼解析

blkmov指令使用例子,ORB-SLAM2代碼解析

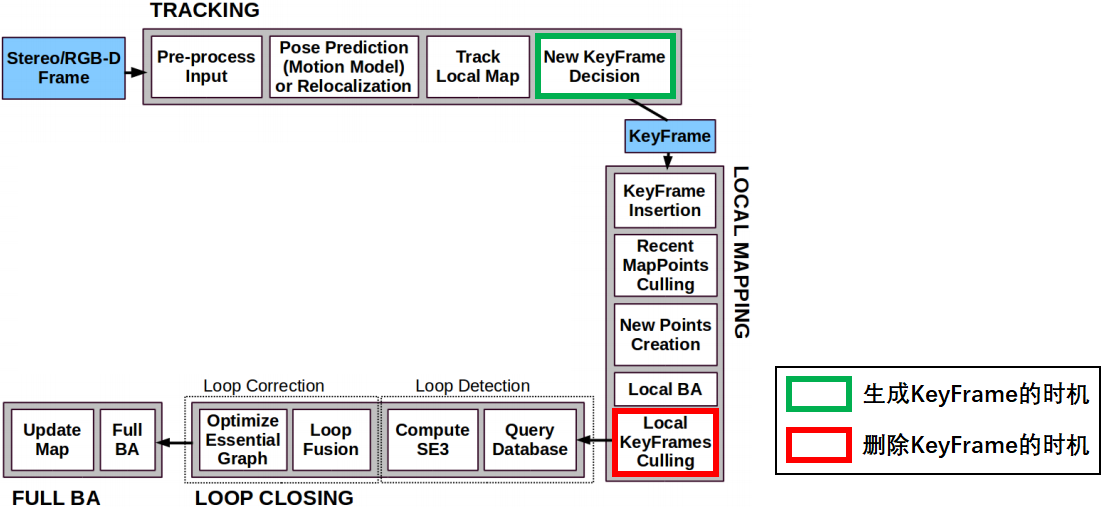

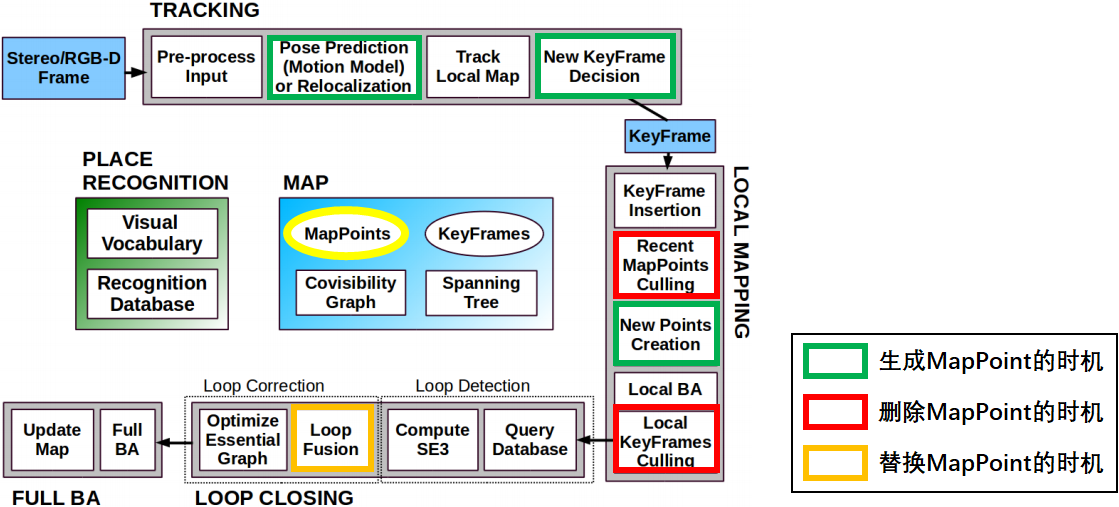

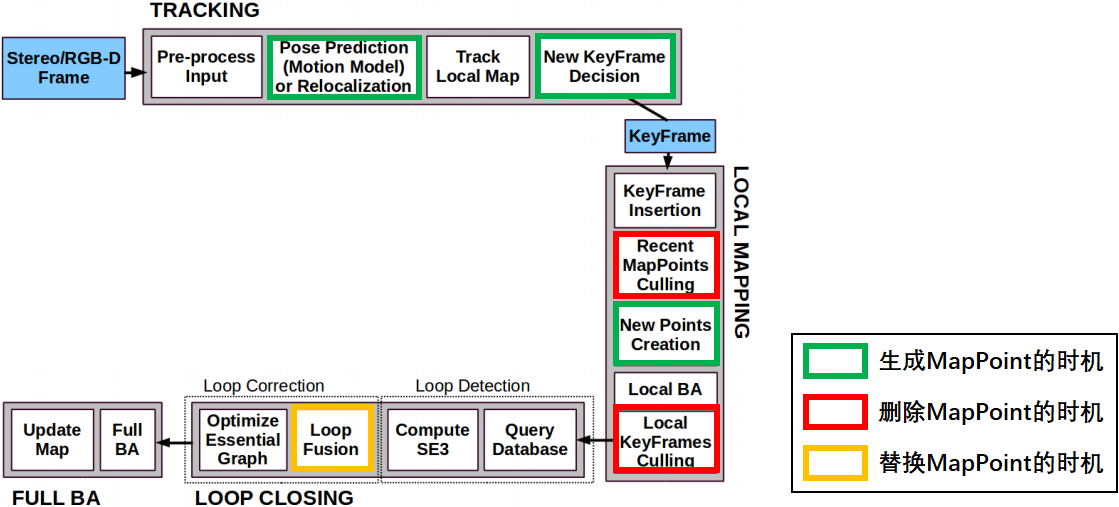

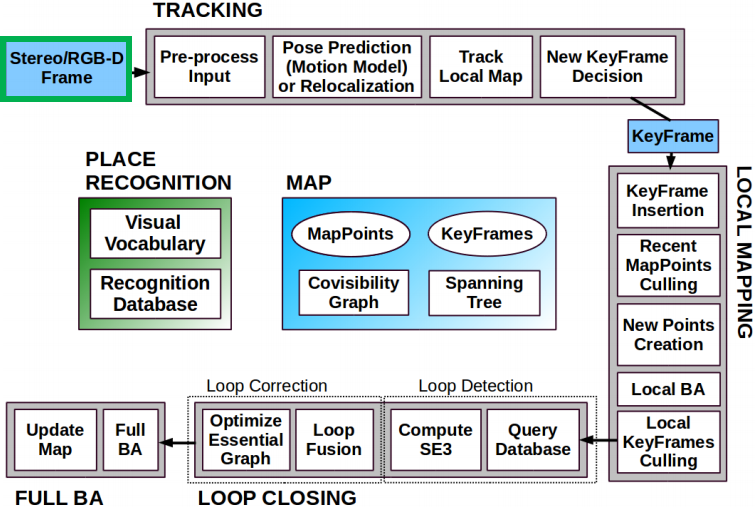

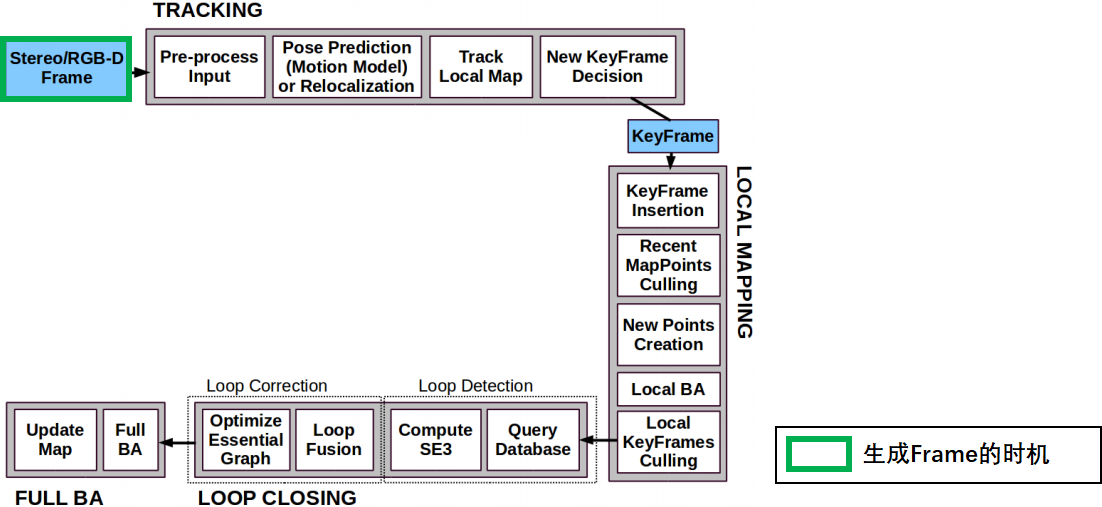

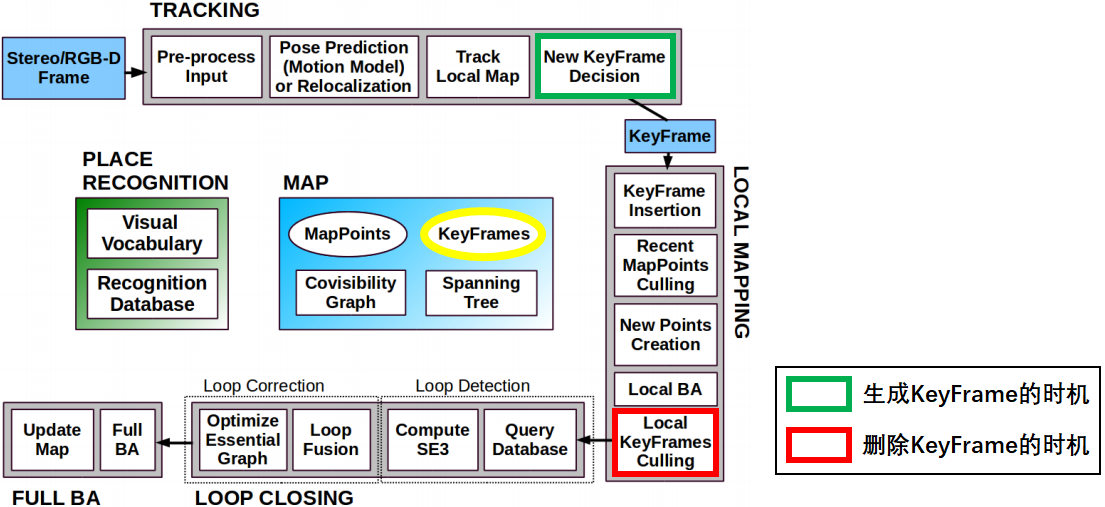

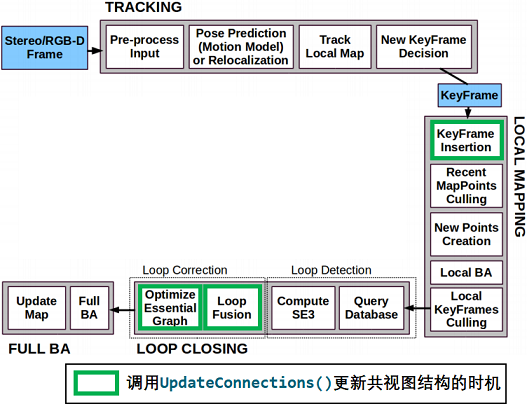

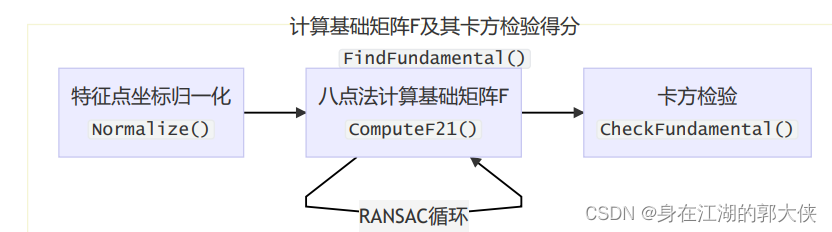

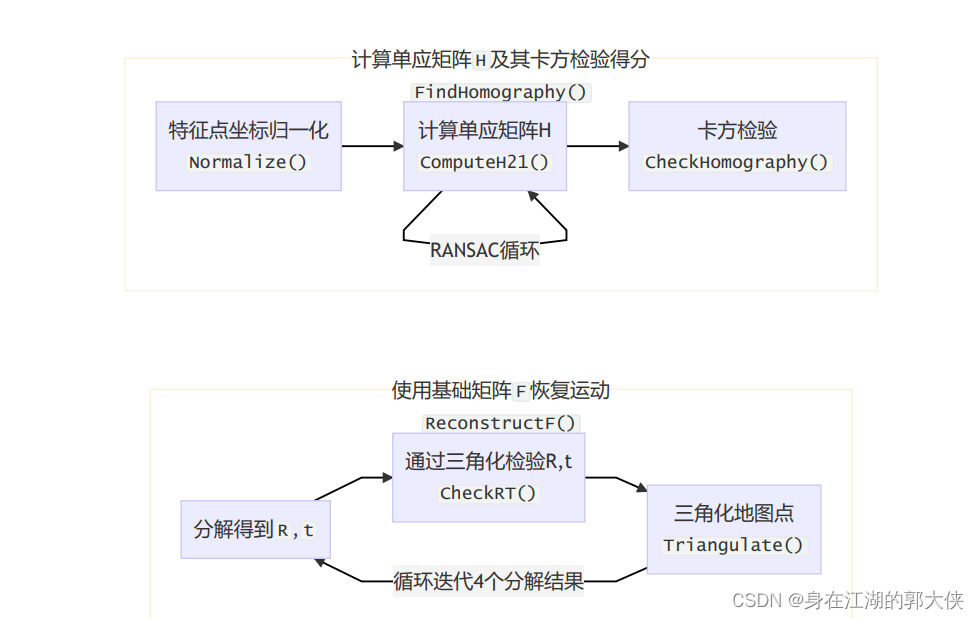

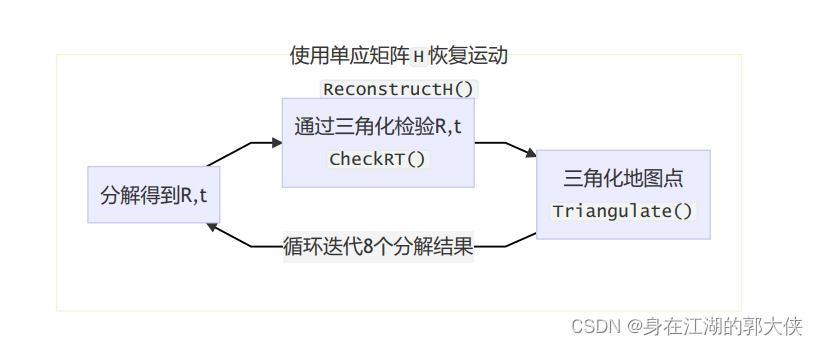

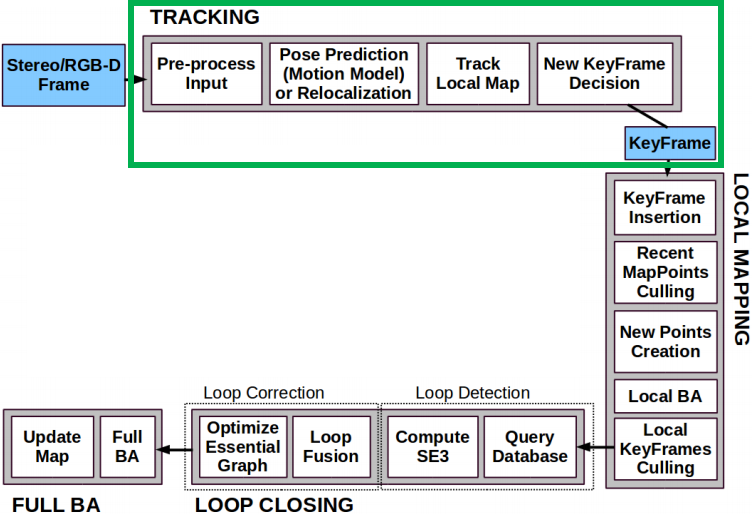

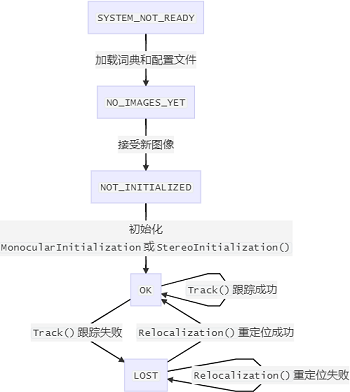

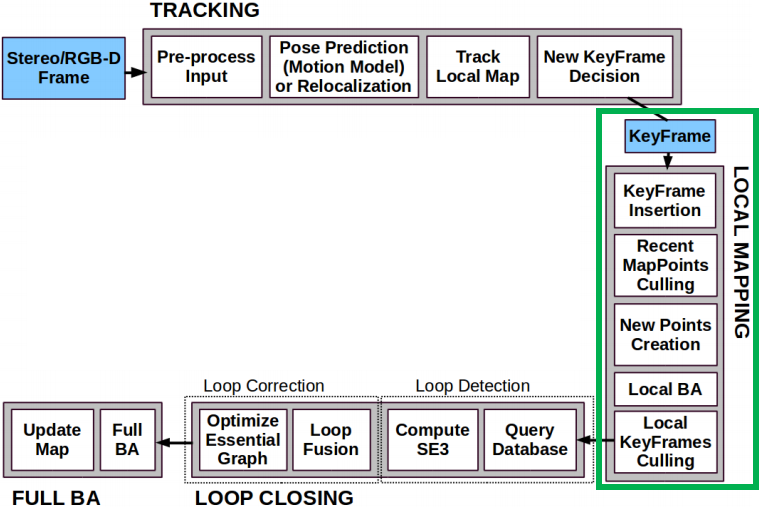

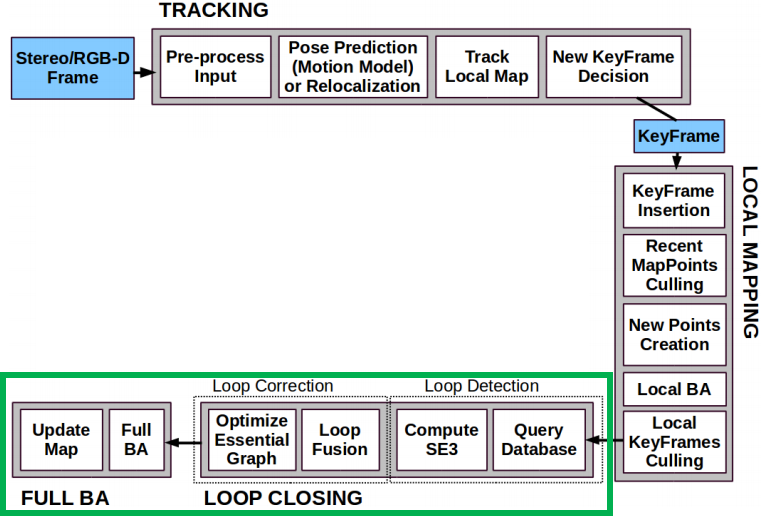

一、算法的主題框架

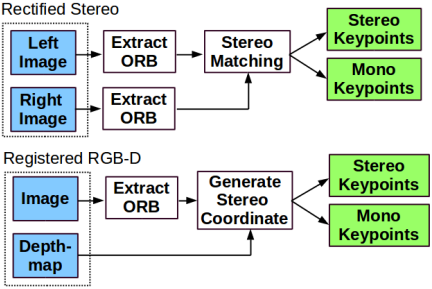

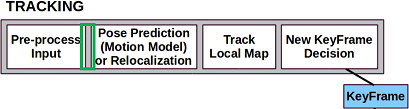

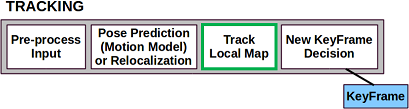

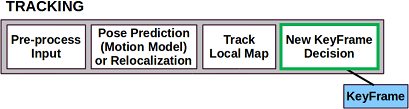

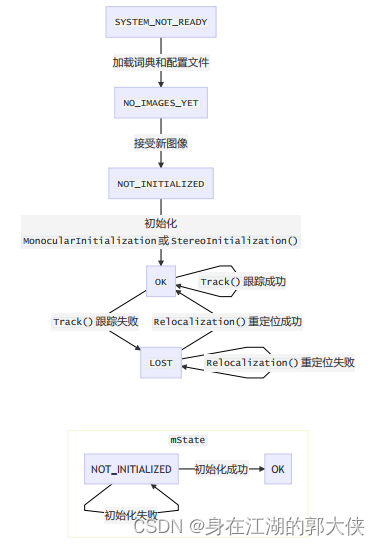

輸入。有三種模式可以選擇:單目模式、雙目模式和RGB-D模式。

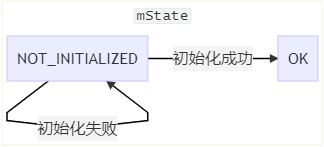

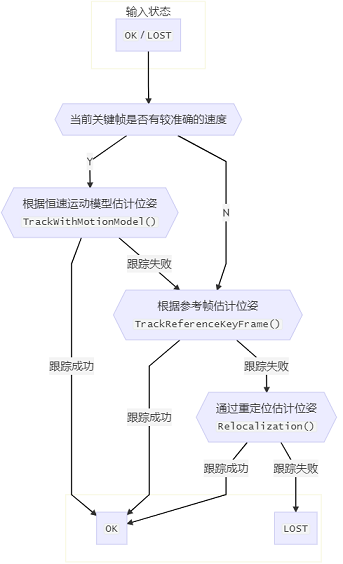

跟蹤。初始化成功后首先會選擇參考關鍵幀跟蹤,然后大部分時間都是恒速模型跟蹤,當跟蹤丟失

的時候啟動重定位跟蹤,在經過以上跟蹤后可以估計初步的位姿,然后經過局部地圖跟蹤對位姿進

行進一步優化。同時會根據條件判斷是否需要將當前幀新建為關鍵幀。

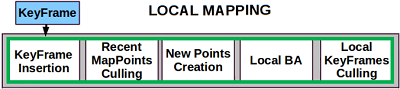

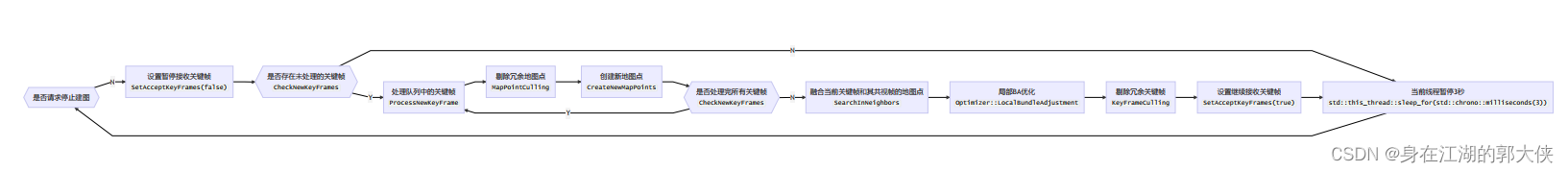

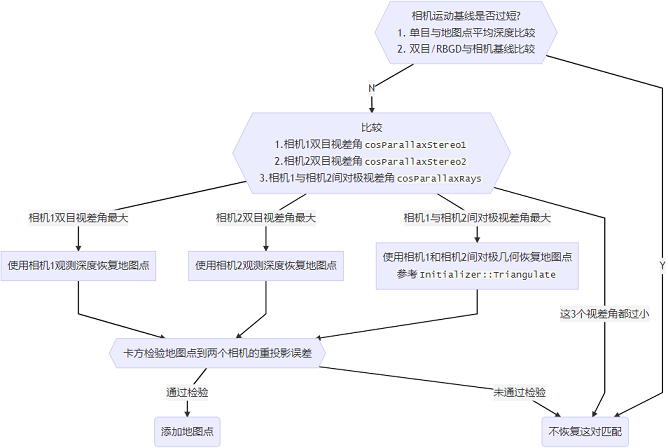

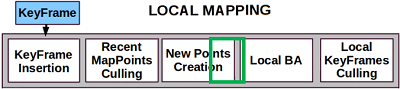

局部建圖。輸入的關鍵幀來自跟蹤里新建的關鍵幀。為了增加局部地圖點數目,局部地圖里關鍵幀

之間會重新進行特征匹配,生成新的地圖點,局部BA會同時優化共視圖里的關鍵幀位姿和地圖點,

優化后也會刪除不準確的地圖點和冗余的關鍵幀。

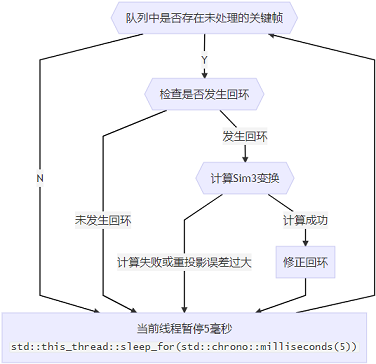

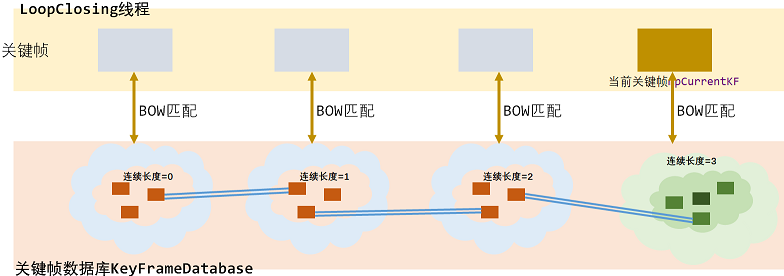

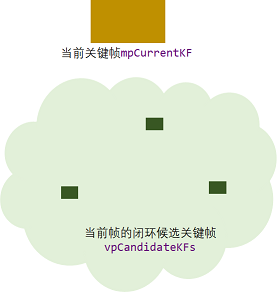

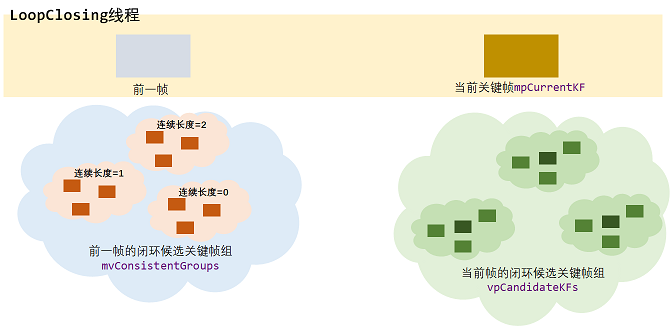

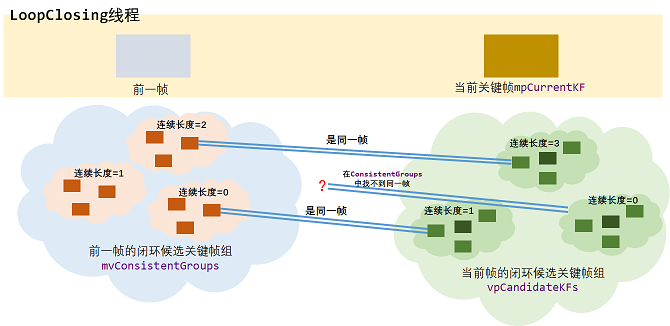

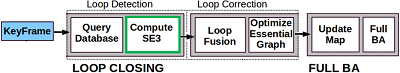

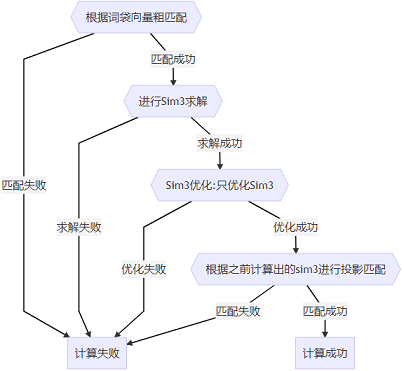

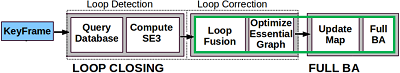

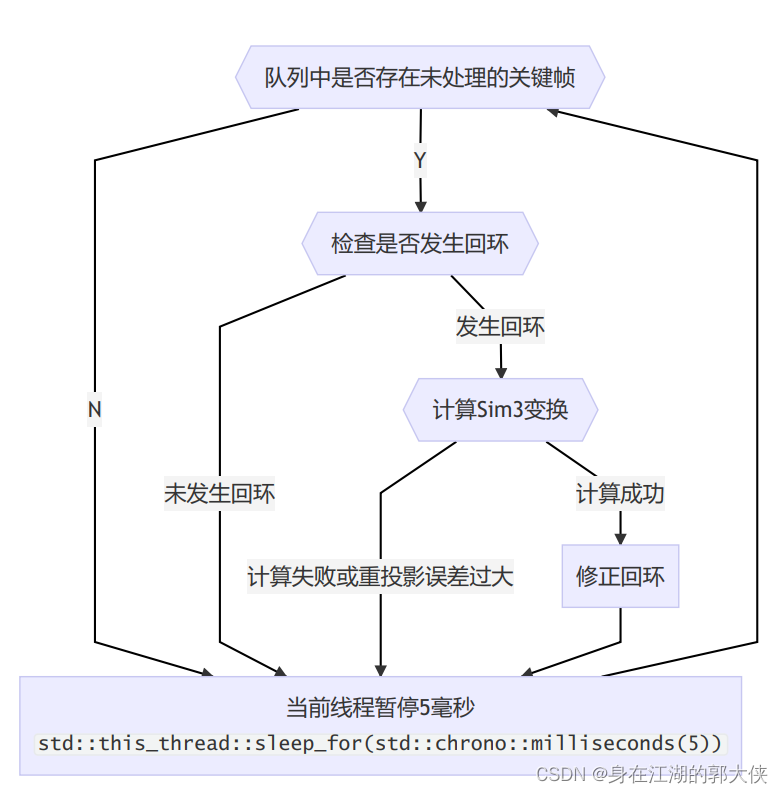

閉環。通過詞袋來查詢數據集檢測是否閉環,計算當前關鍵幀和閉環候選關鍵幀之間的Sim3位姿,

僅在單目時考慮尺度,雙目或RGB-D模式下尺度固定為1。然后執行閉環融合和本質圖優化,使得

所有關鍵幀位姿更準確。

全局BA。優化所有的關鍵幀及其地圖點。

位置識別。需要導入離線訓練好的字典,這個字典是由視覺詞袋模型構建的。新輸入的圖像幀需要

先在線轉化為詞袋向量,主要應用于特征匹配、重定位、閉環。

地圖。地圖主要由地圖點和關鍵幀組成。關鍵幀之間根據共視地圖點數目組成了共視圖,根據父子

關系組成了生成樹

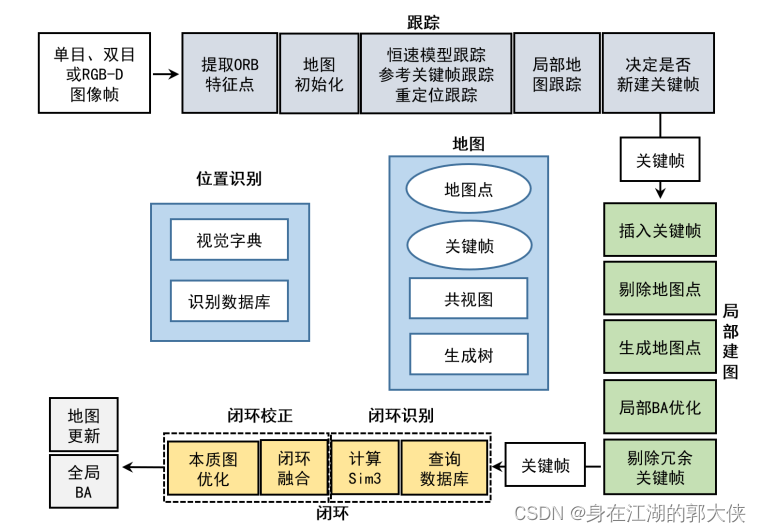

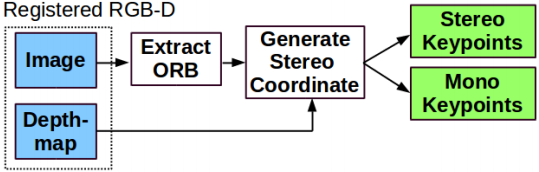

為了兼容不同相機(雙目相機與RGBD相機),需要對輸入數據進行預處理,使得交給后期處理的數

據格式一致,具體流程如下:

blkmov指令使用例子,

?二、代碼

以RGB-D舉例,代碼入口rgbd_tum.cc,默認參數

./Examples/RGB-D/rgbd_tum Vocabulary/ORBvoc.txt Examples/RGB-D/TUM1.yaml PATH_TO_SEQUENCE_FOLDER ASSOCIATIONS_FILE

/**

* This file is part of ORB-SLAM2.

*

* Copyright (C) 2014-2016 Raúl Mur-Artal <raulmur at unizar dot es> (University of Zaragoza)

* For more information see <https://github.com/raulmur/ORB_SLAM2>

*

* ORB-SLAM2 is free software: you can redistribute it and/or modify

* it under the terms of the GNU General Public License as published by

* the Free Software Foundation, either version 3 of the License, or

* (at your option) any later version.

*

* ORB-SLAM2 is distributed in the hope that it will be useful,

* but WITHOUT ANY WARRANTY; without even the implied warranty of

* MERCHANTABILITY or FITNESS FOR A PARTICULAR PURPOSE. See the

* GNU General Public License for more details.

*

* You should have received a copy of the GNU General Public License

* along with ORB-SLAM2. If not, see <http://www.gnu.org/licenses/>.

*/#include<iostream>

#include<algorithm>

#include<fstream>

#include<chrono>#include<opencv2/core/core.hpp>#include<System.h>using namespace std;void LoadImages(const string &strAssociationFilename, vector<string> &vstrImageFilenamesRGB,vector<string> &vstrImageFilenamesD, vector<double> &vTimestamps);int main(int argc, char **argv)

{if(argc != 5){cerr << endl << "Usage: ./rgbd_tum path_to_vocabulary path_to_settings path_to_sequence path_to_association" << endl;return 1;}// Retrieve paths to imagesvector<string> vstrImageFilenamesRGB;vector<string> vstrImageFilenamesD;vector<double> vTimestamps;string strAssociationFilename = string(argv[4]);LoadImages(strAssociationFilename, vstrImageFilenamesRGB, vstrImageFilenamesD, vTimestamps);// Check consistency in the number of images and depthmapsint nImages = vstrImageFilenamesRGB.size();if(vstrImageFilenamesRGB.empty()){cerr << endl << "No images found in provided path." << endl;return 1;}else if(vstrImageFilenamesD.size()!=vstrImageFilenamesRGB.size()){cerr << endl << "Different number of images for rgb and depth." << endl;return 1;}// Create SLAM system. It initializes all system threads and gets ready to process frames.ORB_SLAM2::System SLAM(argv[1],argv[2],ORB_SLAM2::System::RGBD,true);// Vector for tracking time statisticsvector<float> vTimesTrack;vTimesTrack.resize(nImages);cout << endl << "-------" << endl;cout << "Start processing sequence ..." << endl;cout << "Images in the sequence: " << nImages << endl << endl;// Main loopcv::Mat imRGB, imD;for(int ni=0; ni<nImages; ni++){// Read image and depthmap from fileimRGB = cv::imread(string(argv[3])+"/"+vstrImageFilenamesRGB[ni],CV_LOAD_IMAGE_UNCHANGED);imD = cv::imread(string(argv[3])+"/"+vstrImageFilenamesD[ni],CV_LOAD_IMAGE_UNCHANGED);double tframe = vTimestamps[ni];if(imRGB.empty()){cerr << endl << "Failed to load image at: "<< string(argv[3]) << "/" << vstrImageFilenamesRGB[ni] << endl;return 1;}#ifdef COMPILEDWITHC11std::chrono::steady_clock::time_point t1 = std::chrono::steady_clock::now();

#elsestd::chrono::monotonic_clock::time_point t1 = std::chrono::monotonic_clock::now();

#endif// Pass the image to the SLAM systemSLAM.TrackRGBD(imRGB,imD,tframe);#ifdef COMPILEDWITHC11std::chrono::steady_clock::time_point t2 = std::chrono::steady_clock::now();

#elsestd::chrono::monotonic_clock::time_point t2 = std::chrono::monotonic_clock::now();

#endifdouble ttrack= std::chrono::duration_cast<std::chrono::duration<double> >(t2 - t1).count();vTimesTrack[ni]=ttrack;// Wait to load the next framedouble T=0;if(ni<nImages-1)T = vTimestamps[ni+1]-tframe;else if(ni>0)T = tframe-vTimestamps[ni-1];if(ttrack<T)usleep((T-ttrack)*1e6);}// Stop all threadsSLAM.Shutdown();// Tracking time statisticssort(vTimesTrack.begin(),vTimesTrack.end());float totaltime = 0;for(int ni=0; ni<nImages; ni++){totaltime+=vTimesTrack[ni];}cout << "-------" << endl << endl;cout << "median tracking time: " << vTimesTrack[nImages/2] << endl;cout << "mean tracking time: " << totaltime/nImages << endl;// Save camera trajectorySLAM.SaveTrajectoryTUM("CameraTrajectory.txt");SLAM.SaveKeyFrameTrajectoryTUM("KeyFrameTrajectory.txt"); return 0;

}void LoadImages(const string &strAssociationFilename, vector<string> &vstrImageFilenamesRGB,vector<string> &vstrImageFilenamesD, vector<double> &vTimestamps)

{ifstream fAssociation;fAssociation.open(strAssociationFilename.c_str());while(!fAssociation.eof()){string s;getline(fAssociation,s);if(!s.empty()){stringstream ss;ss << s;double t;string sRGB, sD;ss >> t;vTimestamps.push_back(t);ss >> sRGB;vstrImageFilenamesRGB.push_back(sRGB);ss >> t;ss >> sD;vstrImageFilenamesD.push_back(sD);}}

}

其中65行初始化一個System類

ORB_SLAM2::System SLAM(argv[1],argv[2],ORB_SLAM2::System::RGBD,true);System類的成員函數和成員變量如下:

| 成員變量/函數 | 訪問控制 | 意義 |

|---|---|---|

eSensor mSensor | private | 傳感器類型MONOCULAR,STEREO,RGBD |

ORBVocabulary* mpVocabulary | private | ORB字典,保存ORB描述子聚類結果 |

KeyFrameDatabase* mpKeyFrameDatabase | private | 關鍵幀數據庫,保存ORB描述子倒排索引 |

Map* mpMap | private | 地圖 |

Tracking* mpTracker | private | 追蹤器 |

LocalMapping* mpLocalMapper?std::thread* mptLocalMapping | private?private | 局部建圖器 局部建圖線程 |

LoopClosing* mpLoopCloser?std::thread* mptLoopClosing | private?private | 回環檢測器 回環檢測線程 |

Viewer* mpViewer?FrameDrawer* mpFrameDrawer?MapDrawer* mpMapDrawer?std::thread* mptViewer | private?private?private?private | 查看器 幀繪制器 地圖繪制器 查看器線程 |

System(const string &strVocFile, string &strSettingsFile, const eSensor sensor, const bool bUseViewer=true) | public | 構造函數 |

| python代碼解析器?cv::Mat TrackStereo(const cv::Mat &imLeft, const cv::Mat &imRight, const double ×tamp) cv::Mat TrackRGBD(const cv::Mat &im, const cv::Mat &depthmap, const double ×tamp) cv::Mat TrackMonocular(const cv::Mat &im, const double ×tamp) int mTrackingState std::mutex mMutexState | or代碼是什么。

| 代碼解讀器?跟蹤雙目相機,返回相機位姿 跟蹤RGBD相機,返回相機位姿 跟蹤單目相機,返回相機位姿 追蹤狀態 追蹤狀態鎖 |

| 代碼工具?bool mbActivateLocalizationMode bool mbDeactivateLocalizationMode std::mutex mMutexMode void ActivateLocalizationMode() void DeactivateLocalizationMode() | 時間代碼短片解析?

| 開啟/關閉純定位模式 |

| ob100初始化程序實例、

|

orb特征提取算法。 | 系統復位 |

| void Shutdown() | public | 系統關閉 |

| void SaveTrajectoryTUM(const string &filename) void SaveKeyFrameTrajectoryTUM(const string &filename) void SaveTrajectoryKITTI(const string &filename) |

| 以TUM/KITTI格式保存相機運動軌跡和關鍵幀位姿 |

LocalMapping和LoopClosing線程在System類中有對應的std::thread線程成員變量,為什么Tracking線程沒有對應的std::thread成員變量?

因為Tracking線程就是主線程,而LocalMapping和LoopClosing線程是其子線程,主線程通過持有兩個子線程的指針(mptLocalMapping和mptLoopClosing)控制子線程.

(ps: 雖然在編程實現上三大主要線程構成父子關系,但邏輯上我們認為這三者是并發的,不存在誰控制誰的問題).

特征點提取

?

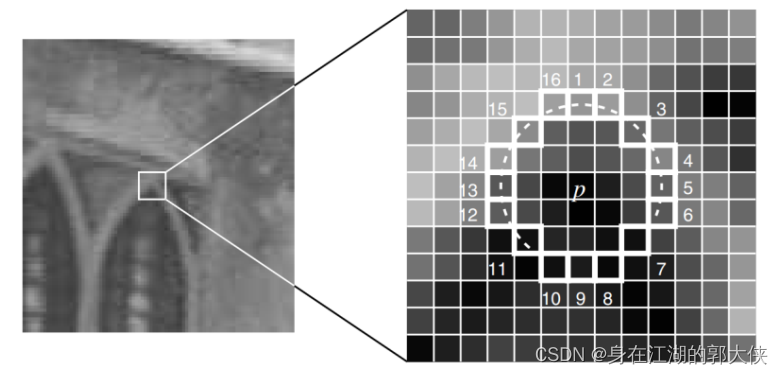

FAST特征點

選取像素p,假設它的亮度為Ip;

設置一個閾值T(比如Ip的20%);

以像素p為中心,選取半徑為3的圓上的16個像素點;

假如選取的圓上,有連續的N個點的亮度大于Ip+T或小于Ip-T,那么像素p可以被認為是特征點;

循環以上4步,對每一個像素執行相同操作。

FAST 描述子

論文:BRIEF: Binary Robust Independent Elementary Features

BRIEF算法的核心思想是在關鍵點P的周圍以一定模式選取N個點對,把這N個點對的比較結果組合起來

作為描述子。為了保持踩點固定,工程上采用特殊設計的固定的pattern來做

?

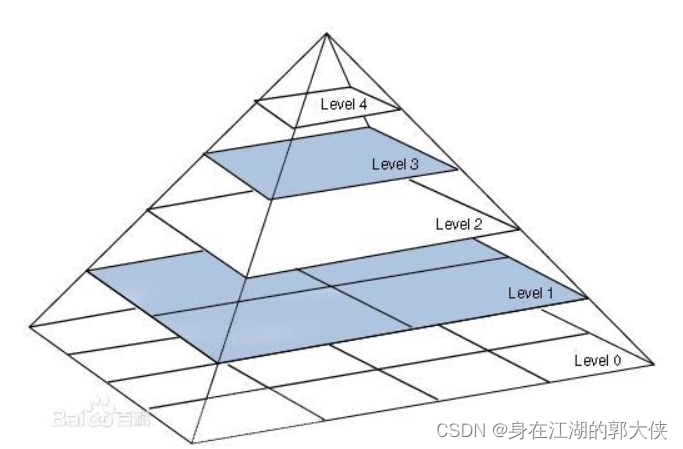

FAST特征點和ORB描述子本身不具有尺度信息,ORBextractor通過構建圖像金字塔來得到特征點尺度信息.將輸入圖片逐級縮放得到圖像金字塔,金字塔層級越高,圖片分辨率越低,ORB特征點越大.

圖像金字塔對應函數為:ORBextractor::ComputePyramid

構造函數ORBextractor(int nfeatures, float scaleFactor, int nlevels, int iniThFAST, int minThFAST)的流程:

1 初始化圖像金字塔相關變量:

下面成員變量從配置文件TUM1.yaml中讀入:

int nfeatures | protected | 所有層級提取到的特征點數之和金字塔層數 | ORBextractor.nFeatures | 1000 |

double scaleFactor | protected | 圖像金字塔相鄰層級間的縮放系數 | ORBextractor.scaleFactor | 1.2 |

int nlevels | protected | 金字塔層級數 | ORBextractor.nLevels | 8 |

int iniThFAST | protected | 提取特征點的描述子門檻(高) | ORBextractor.iniThFAST | 20 |

int minThFAST | protected | 提取特征點的描述子門檻(低) | ORBextractor.minThFAST | 7 |

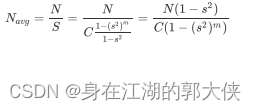

圖像金字塔層數越高,對應層數的圖像分辨率越低,面積(高 寬)越小,所能提取到的特征點數量就

越少。所以分配策略就是根據圖像的面積來定,將總特征點數目根據面積比例均攤到每層圖像上。

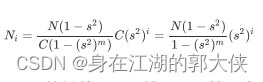

| 我們假設需要提取的特征點數目為 N,金字塔總共有m層,第0層圖像的寬為W,高為H,對應的面積H·W=C,圖像金字塔縮放因子為s,0<s<1,在ORB-SLAM2中,m=8,s= |

單位面積應該分配的特征點數量為:?

?第0層應該分配的特征點數量為:

第i層特征點數量為:

在ORB-SLAM2 的代碼里,不是按照面積均攤的,而是按照面積的開方來均攤特征點的,也就是將上述公式中的 換成 s即可。

根據上述變量的值計算出下述成員變量:

| 成員變量 | 訪問控制 | 意義 | 值 |

|---|---|---|---|

std::vector mnFeaturesPerLevel | protected | 金字塔每層級中提取的特征點數 正比于圖層邊長,總和為nfeatures | {61, 73, 87, 105, 126, 151, 181, 216} |

std::vector mvScaleFactor | protected | 各層級的縮放系數 | {1, 1.2, 1.44, 1.728, 2.074, 2.488, 2.986, 3.583} |

std::vector mvInvScaleFactor | protected | 各層級縮放系數的倒數 | {1, 0.833, 0.694, 0.579, 0.482, 0.402, 0.335, 0.2791} |

std::vector mvLevelSigma2 | protected | 各層級縮放系數的平方 | {1, 1.44, 2.074, 2.986, 4.300, 6.190, 8.916, 12.838} |

std::vector mvInvLevelSigma2 | protected | 各層級縮放系數的平方倒數 | {1, 0.694, 0.482, 0.335, 0.233, 0.162, 0.112, 0.078} |

2 初始化用于計算描述子的pattern變量,pattern是用于計算描述子的256對坐標,其值寫死在源碼文件ORBextractor.cc里,在構造函數里做類型轉換將其轉換為const cv::Point*變量.?

static int bit_pattern_31_[256*4]3 計算半徑為15的圓的近似坐標

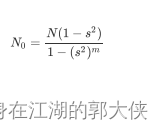

原始的FAST關鍵點沒有方向信息,這樣當圖像發生旋轉后,brief描述子也會發生變化,使得特征點對旋轉不魯棒,解決方案是使用灰度質心法計算特征點的方向,灰度質心法求解如下:

·step1 定義該區域的圖像的矩為:

?該式中,p,q取0或1;

表示在像素坐標

處的灰度值;

表示圖像的矩。在半徑為R的圓形圖像區域,沿兩個坐標軸x,y方向的圖像矩為:

圓形區域內所以像素的灰度值總和為:

·step 2:圖像的質心為:

·step 3 : 在關鍵幀的"主方向”就可以表示為從圓形圖像形心O指向質心C的方向向量,于是關鍵點的旋轉角度記為

以上即為灰度質心法求關鍵點旋轉角度的原理。

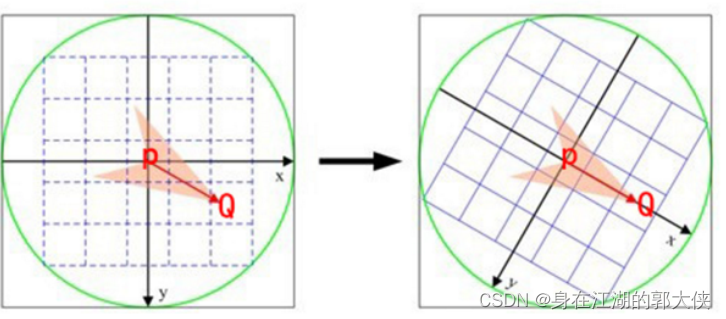

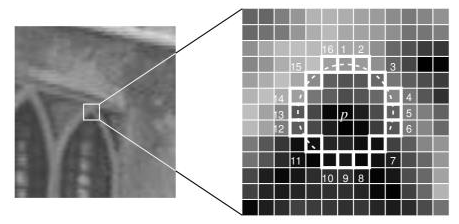

下圖P為幾何中心,Q為灰度質心

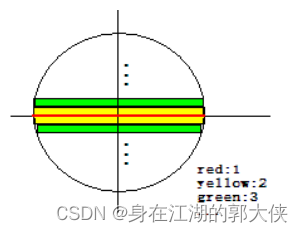

?而為什么是圓而不是正方形是因為:ORBSLAM里面是先旋轉坐標再從圖像中采點提取,并不是先取那塊圖像再旋轉,見computeOrbDescriptor函數里的這個表達式

#define GET_VALUE(idx) \ center[cvRound(pattern[idx].xb + pattern[idx].ya)step + \

cvRound(pattern[idx].xa - pattern[idx].yb)]

會導致下方采集點的時候綠色和黃色部分就是不同的像素

?后面計算的是特征點主方向上的描述子,計算過程中要將特征點周圍像素旋轉到主方向上,因此計算一個半徑為15的圓的近似坐標,用于后面計算描述子時進行旋轉操作.

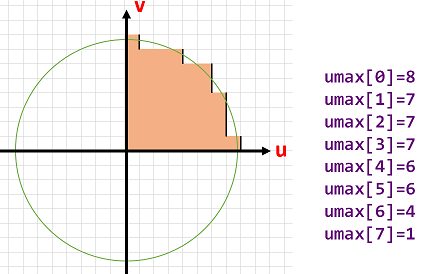

?成員變量std::vector umax里存儲的實際上是逼近圓的第一象限內圓周上每個v坐標對應的u坐標.為保證嚴格對稱性,先計算下45°圓周上點的坐標,再根據對稱性補全上45°圓周上點的坐標

int vmax = cvFloor(HALF_PATCH_SIZE * sqrt(2.f) / 2 + 1); // 45°射線與圓周交點的縱坐標

int vmin = cvCeil(HALF_PATCH_SIZE * sqrt(2.f) / 2); // 45°射線與圓周交點的縱坐標

?

// 先計算下半45度的umax(勾股定理)

for (int v = 0; v <= vmax; ++v) {umax[v] = cvRound(sqrt(15 * 15 - v * v));

}

?

// 根據對稱性補出上半45度的umax

for (int v = HALF_PATCH_SIZE, v0 = 0; v >= vmin; --v) {while (umax[v0] == umax[v0 + 1])++v0;umax[v] = v0;++v0;

}

- cvRound():返回跟參數最接近的整數值,即四舍五入;

- cvFloor():返回不大于參數的最大整數值,即向下取整;

- cvCeil():返回不小于參數的最小整數值,即向上取整;

構建圖像金字塔:ComputePyramid()

根據上述變量的值計算處下述成員變量:

| 成員變量 | 訪問控制 | 意義 |

|---|---|---|

std::vector mvImagePyramid | public | 圖像金字塔每層的圖像 |

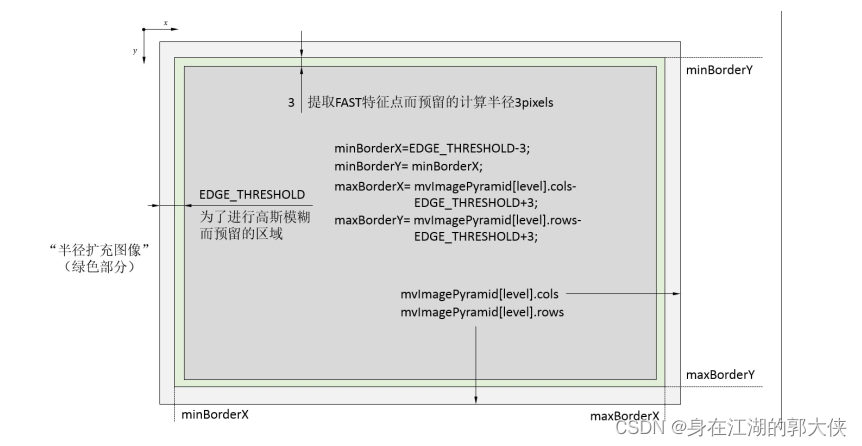

const int EDGE_THRESHOLD | 全局變量 | 為計算描述子和提取特征點補的padding厚度 |

函數void ORBextractor::ComputePyramid(cv::Mat image)逐層計算圖像金字塔,對于每層圖像進行以下兩步:

先進行圖片縮放,縮放到mvInvScaleFactor對應尺寸.

在圖像外補一圈厚度為19的padding(提取FAST特征點需要特征點周圍半徑為3的圓域,計算ORB描述子需要特征點周圍半徑為16的圓域).

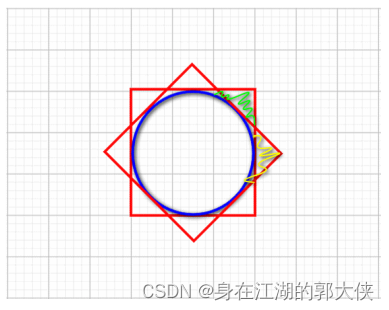

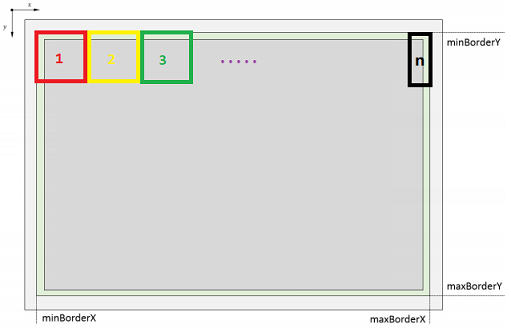

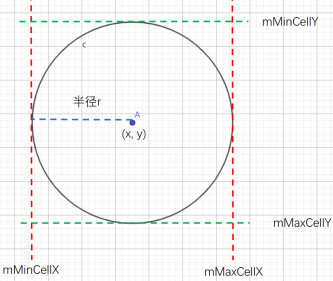

下圖表示圖像金字塔每層結構:

深灰色為縮放后的原始圖像.

包含綠色邊界在內的矩形用于提取FAST特征點.

包含淺灰色邊界在內的整個矩形用于計算ORB描述子.

void ORBextractor::ComputePyramid(cv::Mat image) {for (int level = 0; level < nlevels; ++level) {// 計算縮放+補padding后該層圖像的尺寸float scale = mvInvScaleFactor[level];Size sz(cvRound((float)image.cols*scale), cvRound((float)image.rows*scale));Size wholeSize(sz.width + EDGE_THRESHOLD * 2, sz.height + EDGE_THRESHOLD * 2);Mat temp(wholeSize, image.type());// 縮放圖像并復制到對應圖層并補邊mvImagePyramid[level] = temp(Rect(EDGE_THRESHOLD, EDGE_THRESHOLD, sz.width, sz.height));if( level != 0 ) {resize(mvImagePyramid[level-1], mvImagePyramid[level], sz, 0, 0, cv::INTER_LINEAR);copyMakeBorder(mvImagePyramid[level], temp, EDGE_THRESHOLD, EDGE_THRESHOLD, EDGE_THRESHOLD, EDGE_THRESHOLD, BORDER_REFLECT_101+BORDER_ISOLATED); } else {copyMakeBorder(image, temp, EDGE_THRESHOLD, EDGE_THRESHOLD, EDGE_THRESHOLD, EDGE_THRESHOLD, BORDER_REFLECT_101); }}

}

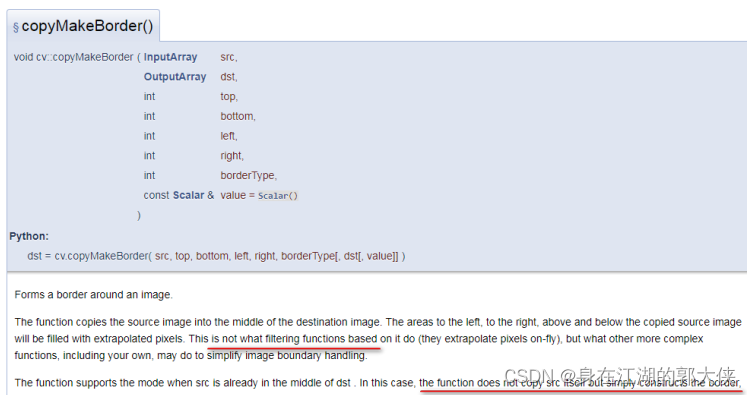

copyMakeBorder函數實現了復制和padding填充,其參數BORDER_REFLECT_101參數指定對padding進行鏡像填充.?

?特征點的提取和篩選:

void ORBextractor::ComputeKeyPointsOctTree(vector<vector<KeyPoint> >& allKeypoints)

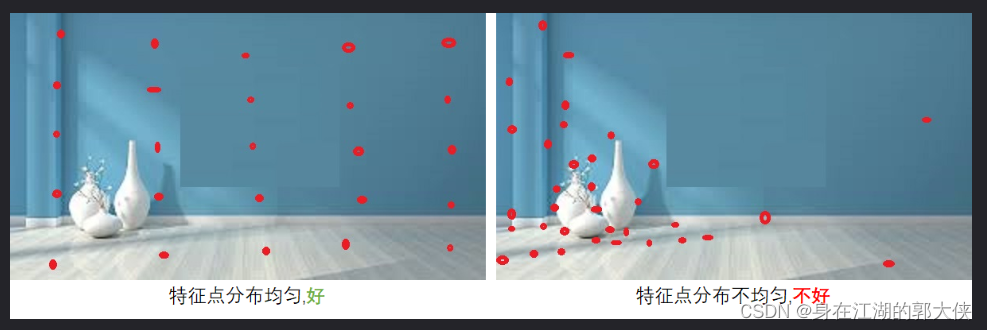

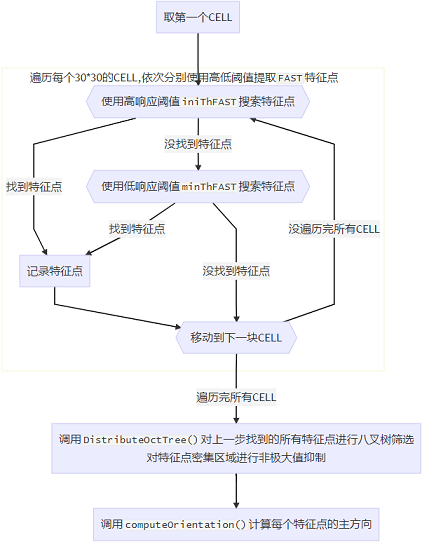

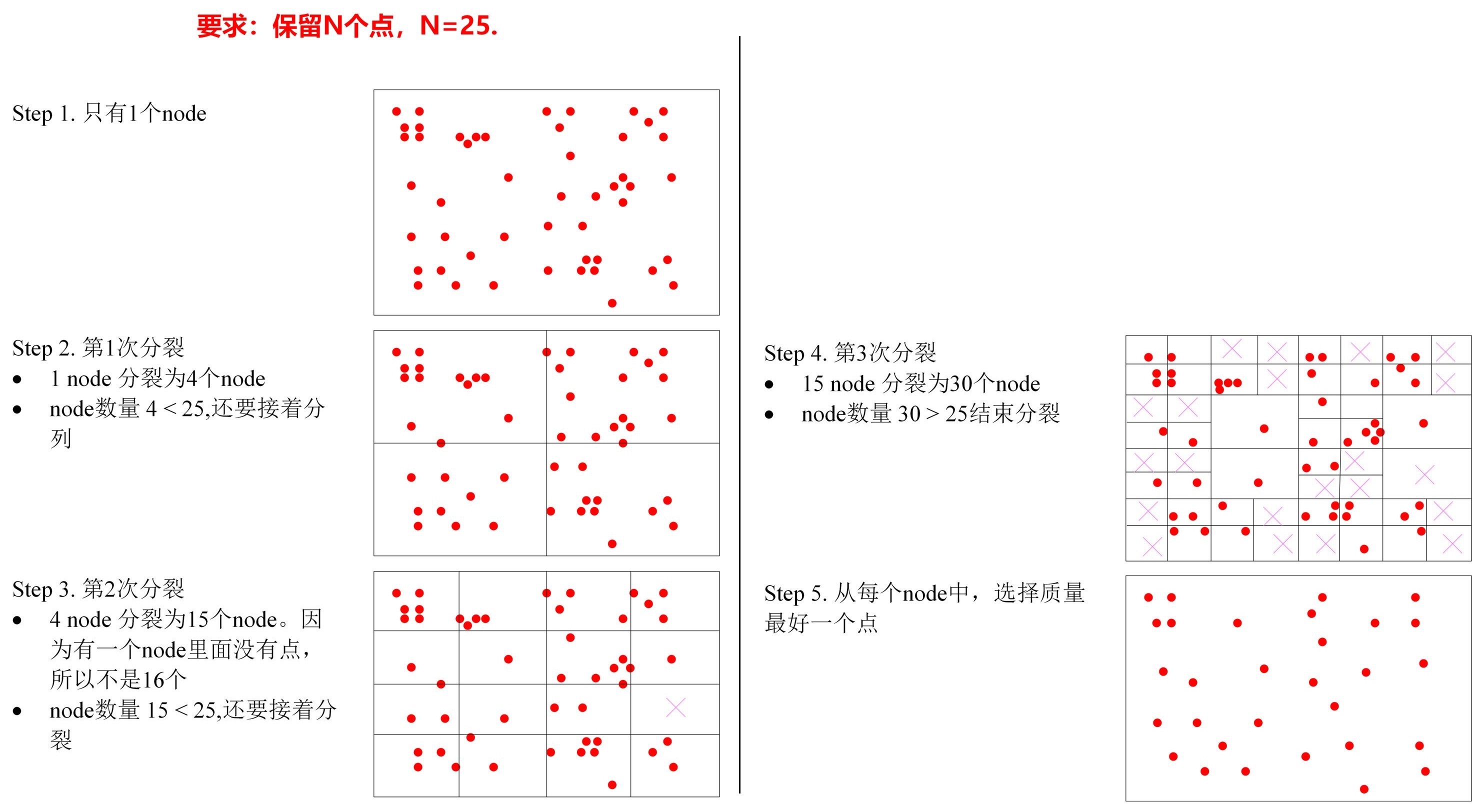

提取特征點最重要的就是力求特征點均勻地分布在圖像的所有部分,為實現這一目標,編程實現上使用了兩個技巧:

·分CELL搜索特征點,若某CELL內特征點響應值普遍較小的話就降低分數線再搜索一遍.

·對得到的所有特征點進行八叉樹篩選,若某區域內特征點數目過于密集,則只取其中響應值最大的那個.

CELL搜索的示意圖如下,每個CELL的大小約為30?30,搜索到邊上,剩余尺寸不夠大的時候,最后一個CELL有多大就用多大的區域.?

?

需要注意的是相鄰的CELL之間會有6像素的重疊區域,因為提取FAST特征點需要計算特征點周圍半徑為3的圓周上的像素點信息,實際上產生特征點的區域比傳入的搜索區域小3像素.

void ORBextractor::ComputeKeyPointsOctTree(vector<vector<KeyPoint> >& allKeypoints) {for (int level = 0; level < nlevels; ++level)// 計算圖像邊界const int minBorderX = EDGE_THRESHOLD-3; const int minBorderY = minBorderX; const int maxBorderX = mvImagePyramid[level].cols-EDGE_THRESHOLD+3;const int maxBorderY = mvImagePyramid[level].rows-EDGE_THRESHOLD+3;const float width = (maxBorderX-minBorderX);const float height = (maxBorderY-minBorderY);const int nCols = width/W; // 每一列有多少cellconst int nRows = height/W; // 每一行有多少cellconst int wCell = ceil(width/nCols); // 每個cell的寬度const int hCell = ceil(height/nRows); // 每個cell的高度

?// 存儲需要進行平均分配的特征點vector<cv::KeyPoint> vToDistributeKeys;// step1. 遍歷每行和每列,依次分別用高低閾值搜索FAST特征點for(int i=0; i<nRows; i++) {const float iniY = minBorderY + i * hCell;const float maxY = iniY + hCell + 6;for(int j=0; j<nCols; j++) {const float iniX =minBorderX + j * wCell;const float maxX = iniX + wCell + 6;vector<cv::KeyPoint> vKeysCell;// 先用高閾值搜索FAST特征點FAST(mvImagePyramid[level].rowRange(iniY,maxY).colRange(iniX,maxX), vKeysCell, iniThFAST, true);// 高閾值搜索不到的話,就用低閾值搜索FAST特征點if(vKeysCell.empty()) {FAST(mvImagePyramid[level].rowRange(iniY,maxY).colRange(iniX,maxX), vKeysCell, minThFAST, true);}// 把 vKeysCell 中提取到的特征點全添加到 容器vToDistributeKeys 中for(KeyPoint point :vKeysCell) {point.pt.x+=j*wCell;point.pt.y+=i*hCell;vToDistributeKeys.push_back(point);}}}// step2. 對提取到的特征點進行八叉樹篩選,見 DistributeOctTree() 函數keypoints = DistributeOctTree(vToDistributeKeys, minBorderX, maxBorderX, minBorderY, maxBorderY, mnFeaturesPerLevel[level], level);}// 計算每個特征點的方向for (int level = 0; level < nlevels; ++level)computeOrientation(mvImagePyramid[level], allKeypoints[level], umax); }

}

八叉樹篩選特征點:

vector<cv::KeyPoint> ORBextractor::DistributeOctTree(const vector<cv::KeyPoint>& vToDistributeKeys, const int &minX,const int &maxX, const int &minY, const int &maxY, const int &N, const int &level)函數DistributeOctTree()進行八叉樹篩選(非極大值抑制),不斷將存在特征點的圖像區域進行4等分,直到分出了足夠多的分區,每個分區內只保留響應值最大的特征點.

其代碼實現比較瑣碎,程序里還定義了一個ExtractorNode類用于進行八叉樹分配

?計算特征點方向?

static void computeOrientation(const Mat& image, vector<KeyPoint>& keypoints, const vector<int>& umax)函數computeOrientation()計算每個特征點的方向: 使用特征點周圍半徑19大小的圓的重心方向作為特征點方向.

static void computeOrientation(const Mat& image, vector<KeyPoint>& keypoints, const vector<int>& umax)

{for (vector<KeyPoint>::iterator keypoint : keypoints) {// 調用IC_Angle 函數計算這個特征點的方向keypoint->angle = IC_Angle(image, keypoint->pt, umax); }

}

?

static float IC_Angle(const Mat& image, Point2f pt, const vector<int> & u_max)

{int m_01 = 0, m_10 = 0; // 重心方向const uchar* center = &image.at<uchar> (cvRound(pt.y), cvRound(pt.x));for (int u = -HALF_PATCH_SIZE; u <= HALF_PATCH_SIZE; ++u)m_10 += u * center[u];int step = (int)image.step1();for (int v = 1; v <= HALF_PATCH_SIZE; ++v) {int v_sum = 0;int d = u_max[v];for (int u = -d; u <= d; ++u) {int val_plus = center[u + v*step], val_minus = center[u - v*step];v_sum += (val_plus - val_minus);m_10 += u * (val_plus + val_minus);}m_01 += v * v_sum;}

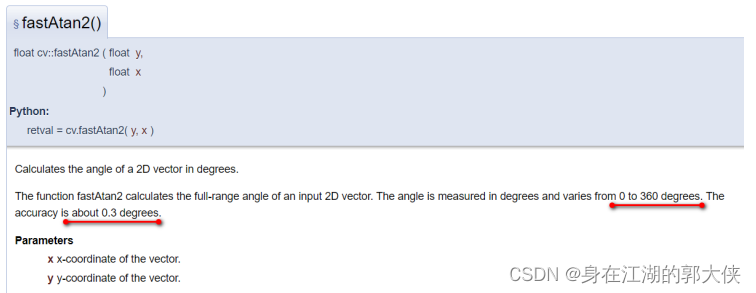

?// 為了加快速度使用了fastAtan2()函數,輸出為[0,360)角度,精度為0.3°return fastAtan2((float)m_01, (float)m_10);

}

IC_Angle 計算技巧

在一個圓域中算出m10(x坐標)和m01(y坐標),計算步驟是先算出中間紅線的m10,然后在平行于

x軸算出m10和m01,一次計算相當于圖像中的同個顏色的兩個line。

計算BRIEF描述子的核心步驟是在特征點周圍半徑為16的圓域內選取256對點對,每個點對內比較得到1位,共得到256位的描述子,為保計算的一致性,工程上使用特定設計的點對pattern,在程序里被硬編碼為成員變量了.

在computeOrientation()中我們求出了每個特征點的主方向,在計算描述子時,應該將特征點周圍像素旋轉到主方向上來計算;為了編程方便,實踐上對pattern進行旋轉.

?

static void computeOrbDescriptor(const KeyPoint& kpt, const Mat& img, const Point* pattern, uchar* desc) {float angle = (float)kpt.angle*factorPI;float a = (float)cos(angle), b = (float)sin(angle);

?const uchar* center = &img.at<uchar>(cvRound(kpt.pt.y), cvRound(kpt.pt.x));const int step = (int)img.step;

?// 旋轉公式// x'= xcos(θ) - ysin(θ)// y'= xsin(θ) + ycos(θ)#define GET_VALUE(idx) \center[cvRound(pattern[idx].x*b + pattern[idx].y*a)*step + cvRound(pattern[idx].x*a - pattern[idx].y*b)] for (int i = 0; i < 32; ++i, pattern += 16) {int t0, t1, val;t0 = GET_VALUE(0); t1 = GET_VALUE(1);val = t0 < t1; // 描述子本字節的bit0t0 = GET_VALUE(2); t1 = GET_VALUE(3);val |= (t0 < t1) << 1; // 描述子本字節的bit1t0 = GET_VALUE(4); t1 = GET_VALUE(5);val |= (t0 < t1) << 2; // 描述子本字節的bit2t0 = GET_VALUE(6); t1 = GET_VALUE(7);val |= (t0 < t1) << 3; // 描述子本字節的bit3t0 = GET_VALUE(8); t1 = GET_VALUE(9);val |= (t0 < t1) << 4; // 描述子本字節的bit4t0 = GET_VALUE(10); t1 = GET_VALUE(11);val |= (t0 < t1) << 5; // 描述子本字節的bit5t0 = GET_VALUE(12); t1 = GET_VALUE(13);val |= (t0 < t1) << 6; // 描述子本字節的bit6t0 = GET_VALUE(14); t1 = GET_VALUE(15);val |= (t0 < t1) << 7; // 描述子本字節的bit7

?//保存當前比較的出來的描述子的這個字節desc[i] = (uchar)val;}

}

ORBextractor類提取特征點的主函數void operator()()

這個函數重載了()運算符,使得其他類可以將ORBextractor類型變量當作函數來使用.

該函數是ORBextractor的主函數,內部依次調用了上面提到的各過程.

[外鏈圖片轉存失敗,源站可能有防盜鏈機制,建議將圖片保存下來直接上傳(img-iRpb6G9u-1651331512006)(…/AppData/Roaming/Typora/typora-user-images/1628640469328.png)]

提取特征點void operator()()計算特征點并進行八叉樹篩選

ComputeKeyPointsOctTree()檢查圖像有效性計算特征點并進行八叉樹篩選

ComputeKeyPointsOctTree()遍歷每一層圖像,計算描述子

computeOrbDescriptor()逐層遍歷

按CELL提取FAST特征點調用DistributeOctTree()

篩選特征點,進行非極大值抑制調用computeOrientation()

計算每個特征點的主方向

為什么要重載小括號運算符 operator() ?

可以用于仿函數(一個可以實現函數功能的對象)

仿函數(functor)又稱為函數對象(function object)是一個能行使函數功能的類。仿函數的語法幾乎

和我們普通的函數調用一樣,不過作為仿函數的類,都必須重載operator()運算符

1.仿函數可有擁有自己的數據成員和成員變量,這意味著這意味著仿函數擁有狀態。這在一般函數中是

不可能的。

2.仿函數通常比一般函數有更好的速度。

void ORBextractor::operator()(InputArray _image, InputArray _mask, vector<KeyPoint>& _keypoints, OutputArray _descriptors) { // step1. 檢查圖像有效性if(_image.empty())return;Mat image = _image.getMat();assert(image.type() == CV_8UC1 );

?// step2. 構建圖像金字塔ComputePyramid(image);

?// step3. 計算特征點并進行八叉樹篩選vector<vector<KeyPoint> > allKeypoints; ComputeKeyPointsOctTree(allKeypoints);

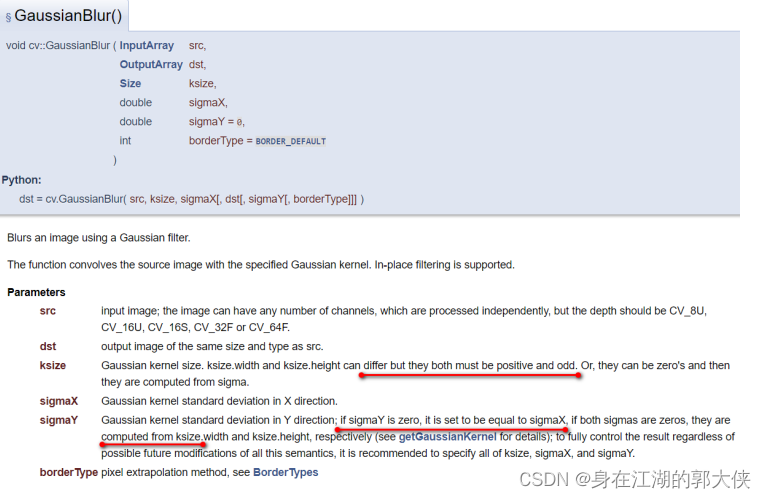

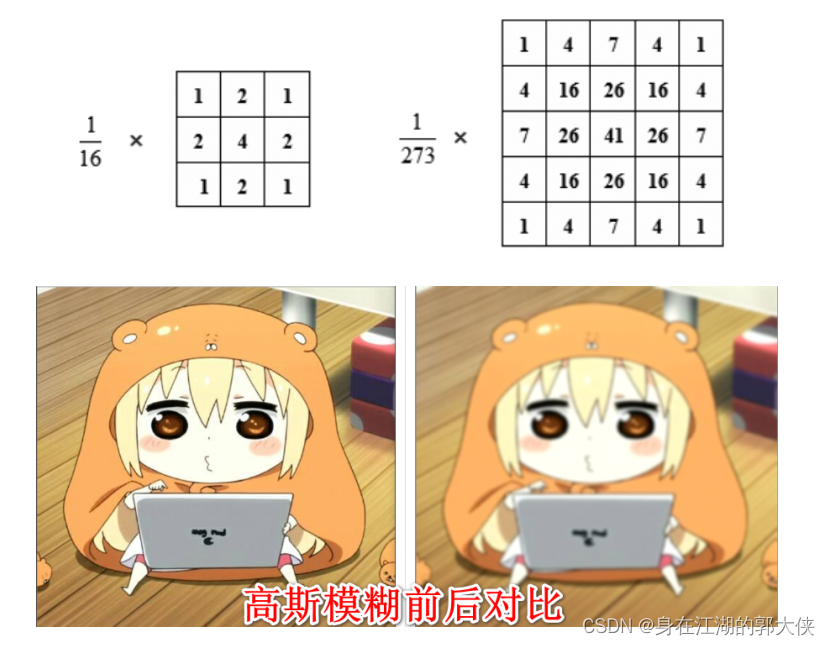

?// step4. 遍歷每一層圖像,計算描述子int offset = 0;for (int level = 0; level < nlevels; ++level) {Mat workingMat = mvImagePyramid[level].clone();// 計算描述子之前先進行一次高斯模糊GaussianBlur(workingMat, workingMat, Size(7, 7), 2, 2, BORDER_REFLECT_101);computeDescriptors(workingMat, allKeypoints[level], descriptors.rowRange(offset, offset + allKeypoints[level].size());, pattern);offset += allKeypoints[level].size();}

}

高斯公式:

這個重載()運算符的用法被用在Frame類的ExtractORB()函數中了,這也是ORBextractor類在整個項目中唯一被調用的地方.

// 函數中`mpORBextractorLeft`和`mpORBextractorRight`都是`ORBextractor`對象

void Frame::ExtractORB(int flag, const cv::Mat &im) {if(flag==0)(*mpORBextractorLeft)(im, cv::Mat(), mvKeys, mDescriptors);else(*mpORBextractorRight)(im,cv::Mat(),mvKeysRight,mDescriptorsRight);

}ORBextractor類與其他類間的關系

Frame類中與ORBextractor有關的成員變量和成員函數

| 成員變量/函數 | 訪問控制 | 意義 |

|---|---|---|

ORBextractor* mpORBextractorLeft | public | 左目特征點提取器 |

ORBextractor* mpORBextractorRight | public | 右目特征點提取器,單目/RGBD模式下為空指針 |

Frame() | public | Frame類的構造函數,其中調用ExtractORB()函數進行特征點提取 |

ExtractORB() | public | 提取ORB特征點,其中調用了mpORBextractorLeft和mpORBextractorRight的()方法 |

// Frame類的兩個ORBextractor是在調用構造函數時傳入的,構造函數中調用ExtractORB()提取特征點

Frame::Frame(ORBextractor *extractorLeft, ORBextractor *extractorRight) : mpORBextractorLeft(extractorLeft), mpORBextractorRight(extractorRight) {

?// ...

?// 提取ORB特征點thread threadLeft(&Frame::ExtractORB, this, 0, imLeft);thread threadRight(&Frame::ExtractORB, this, 1, imRight);threadLeft.join();threadRight.join();

?// ... }

?

// 提取特征點

void Frame::ExtractORB(int flag, const cv::Mat &im) {if (flag == 0)(*mpORBextractorLeft)(im, cv::Mat(), mvKeys, mDescriptors);else(*mpORBextractorRight)(im, cv::Mat(), mvKeysRight, mDescriptorsRight);

}

Frame類的兩個ORBextractor指針指向的變量是Tracking類的構造函數中創建的

// Tracking構造函數

Tracking::Tracking() {// ...// 創建兩個ORB特征點提取器mpORBextractorLeft = new ORBextractor(nFeatures, fScaleFactor, nLevels, fIniThFAST, fMinThFAST);if (sensor == System::STEREO)mpORBextractorRight = new ORBextractor(nFeatures, fScaleFactor, nLevels, fIniThFAST, fMinThFAST);

?// ...

}

?

// Tracking線程每收到一幀輸入圖片,就創建一個Frame對象,創建Frame對象時將提取器mpORBextractorLeft和mpORBextractorRight給構造函數

cv::Mat Tracking::GrabImageStereo(const cv::Mat &imRectLeft, const cv::Mat &imRectRight, const double ×tamp) {// ...// 創建Frame對象mCurrentFrame = Frame(mImGray, imGrayRight, timestamp, mpORBextractorLeft, mpORBextractorRight);// ...

}

由上述代碼分析可知,每次完成ORB特征點提取之后,圖像金字塔信息就作廢了,下一幀圖像到來時調用ComputePyramid()函數會覆蓋掉本幀圖像的圖像金字塔信息;但從金字塔中提取的圖像特征點的信息會被保存在Frame對象中.所以ORB-SLAM2是稀疏重建,對每幀圖像只保留最多nfeatures個特征點(及其對應的地圖點).

?

構造函數ORBextractor()初始化圖像金字塔相關變量初始化用于計算描述子的pattern計算近似圓形的邊界坐標umax

遍歷每個30*30的CELL,依次分別使用高低閾值提取FAST特征點找到特征點找到特征點沒找到特征點沒找到特征點沒遍歷完所有CELL遍歷完所有CELL使用高響應閾值iniThFAST搜索特征點使用低響應閾值minThFAST搜索特征點記錄特征點移動到下一塊CELL取第一個CELL調用DistributeOctTree()對上一步找到的所有特征點進行八叉樹篩選

對特征點密集區域進行非極大值抑制調用computeOrientation()計算每個特征點的主方向

ORB-SLAM2代碼詳解03_地圖點MapPoint

3.1 各成員函數/變量

3.1.1 地圖點的世界坐標:?mWorldPos

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

cv::Mat mWorldPos | protected | 地圖點的世界坐標 |

cv::Mat GetWorldPos() | public | mWorldPos的get方法 |

void SetWorldPos(const cv::Mat &Pos) | public | mWorldPos的set方法 |

std::mutex mMutexPos | protected | mWorldPos的鎖 |

3.1.2 與關鍵幀的觀測關系:?mObservations

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

std::map mObservations | protected | 當前地圖點在某KeyFrame中的索引 |

map GetObservations() | public | mObservations的get方法 |

void AddObservation(KeyFrame* pKF,size_t idx) | public | 添加當前地圖點對某KeyFrame的觀測 |

void EraseObservation(KeyFrame* pKF) | public | 刪除當前地圖點對某KeyFrame的觀測 |

bool IsInKeyFrame(KeyFrame* pKF) | public | 查詢當前地圖點是否在某KeyFrame中 |

int GetIndexInKeyFrame(KeyFrame* pKF) | public | 查詢當前地圖點在某KeyFrame中的索引 |

int nObs | public | 記錄當前地圖點被多少相機觀測到 單目幀每次觀測加1,雙目幀每次觀測加2 |

int Observations() | public | nObs的get方法 |

成員變量std::map mObservations保存了當前關鍵點對關鍵幀KeyFrame的觀測關系,std::map是一個key-value結構,其key為某個關鍵幀,value為當前地圖點在該關鍵幀中的索引(是在該關鍵幀成員變量std::vector mvpMapPoints中的索引).

成員int nObs記錄了當前地圖點被多少個關鍵幀相機觀測到了(單目關鍵幀每次觀測算1個相機,雙目/RGBD幀每次觀測算2個相機).

函數AddObservation()和EraseObservation()同時維護mObservations和nObs

// 向參考幀pKF中添加對本地圖點的觀測,本地圖點在pKF中的編號為idx

void MapPoint::AddObservation(KeyFrame* pKF, size_t idx) {unique_lock<mutex> lock(mMutexFeatures);// 如果已經添加過觀測,返回if(mObservations.count(pKF)) return;// 如果沒有添加過觀測,記錄下能觀測到該MapPoint的KF和該MapPoint在KF中的索引mObservations[pKF]=idx;

?// 根據觀測形式是單目還是雙目更新觀測計數變量nObsif(pKF->mvuRight[idx]>=0)nObs += 2; elsenObs++;

}

// 從參考幀pKF中移除本地圖點

void MapPoint::EraseObservation(KeyFrame* pKF) {bool bBad=false;{unique_lock<mutex> lock(mMutexFeatures);// 查找這個要刪除的觀測,根據單目和雙目類型的不同從其中刪除當前地圖點的被觀測次數if(mObservations.count(pKF)) {if(pKF->mvuRight[mObservations[pKF]]>=0)nObs-=2;elsenObs--;

?mObservations.erase(pKF);

?// 如果該keyFrame是參考幀,該Frame被刪除后重新指定RefFrameif(mpRefKF == pKF)mpRefKF = mObservations.begin()->first; // ????參考幀指定得這么草率真的好么?

?// 當觀測到該點的相機數目少于2時,丟棄該點(至少需要兩個觀測才能三角化)if(nObs<=2)bBad=true;}}

?if(bBad)// 告知可以觀測到該MapPoint的Frame,該MapPoint已被刪除SetBadFlag();

}

函數GetIndexInKeyFrame()和IsInKeyFrame()就是對mObservations的簡單查詢

int MapPoint::GetIndexInKeyFrame(KeyFrame *pKF) {unique_lock<mutex> lock(mMutexFeatures);if(mObservations.count(pKF))return mObservations[pKF];elsereturn -1;

}

?

bool MapPoint::IsInKeyFrame(KeyFrame *pKF) {unique_lock<mutex> lock(mMutexFeatures);return (mObservations.count(pKF));

}

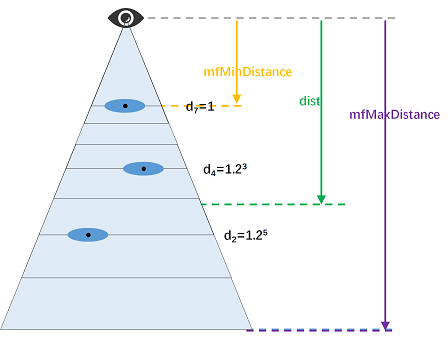

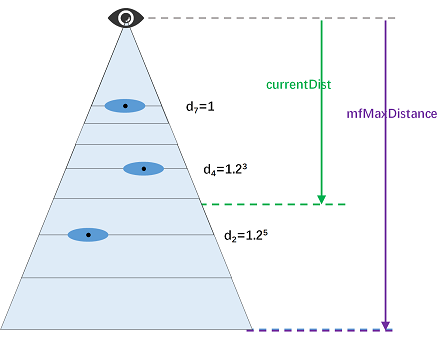

3.2.1 平均觀測距離:?mfMinDistance和mfMaxDistance

特征點的觀測距離與其在圖像金字塔中的圖層呈線性關系.直觀上理解,如果一個圖像區域被放大后才能識別出來,說明該區域的觀測深度較深.

特征點的平均觀測距離的上下限由成員變量mfMaxDistance和mfMinDistance表示:

mfMaxDistance表示若地圖點匹配在某特征提取器圖像金字塔第7層上的某特征點,觀測距離值

mfMinDistance表示若地圖點匹配在某特征提取器圖像金字塔第0層上的某特征點,觀測距離值

這兩個變量是基于地圖點在其參考關鍵幀上的觀測得到的.

// pFrame是當前MapPoint的參考幀

const int level = pFrame->mvKeysUn[idxF].octave;

const float levelScaleFactor = pFrame->mvScaleFactors[level];

const int nLevels = pFrame->mnScaleLevels;

mfMaxDistance = dist*levelScaleFactor;

mfMinDistance = mfMaxDistance/pFrame->mvScaleFactors[nLevels-1];

函數int PredictScale(const float ¤tDist, KeyFrame* pKF)和int PredictScale(const float ¤tDist, Frame* pF)根據某地圖點到某幀的觀測深度估計其在該幀圖片上的層級,是上述過程的逆運算.

int MapPoint::PredictScale(const float ¤tDist, KeyFrame* pKF) {float ratio;{unique_lock<mutex> lock(mMutexPos);ratio = mfMaxDistance/currentDist;}

?int nScale = ceil(log(ratio)/pKF->mfLogScaleFactor);if(nScale<0)nScale = 0;else if(nScale>=pKF->mnScaleLevels)nScale = pKF->mnScaleLevels-1;

?return nScale;

}

3.3 更新平均觀測方向和距離:?UpdateNormalAndDepth()

函數UpdateNormalAndDepth()更新當前地圖點的平均觀測方向和距離,其中平均觀測方向是根據mObservations中所有觀測到本地圖點的關鍵幀取平均得到的;平均觀測距離是根據參考關鍵幀得到的.

void MapPoint::UpdateNormalAndDepth() {// step1. 獲取地圖點相關信息map<KeyFrame *, size_t> observations;KeyFrame *pRefKF;cv::Mat Pos;{unique_lock<mutex> lock1(mMutexFeatures);unique_lock<mutex> lock2(mMutexPos);

?observations = mObservations;pRefKF = mpRefKF; Pos = mWorldPos.clone(); }

?// step2. 根據觀測到但錢地圖點的關鍵幀取平均計算平均觀測方向cv::Mat normal = cv::Mat::zeros(3, 1, CV_32F);int n = 0;for (KeyFrame *pKF : observations.begin()) {normal = normal + normali / cv::norm(mWorldPos - pKF->GetCameraCenter());n++;}

?// step3. 根據參考幀計算平均觀測距離cv::Mat PC = Pos - pRefKF->GetCameraCenter(); const float dist = cv::norm(PC); const int level = pRefKF->mvKeysUn[observations[pRefKF]].octave;const float levelScaleFactor = pRefKF->mvScaleFactors[level]; const int nLevels = pRefKF->mnScaleLevels;

?{unique_lock<mutex> lock3(mMutexPos);mfMaxDistance = dist * levelScaleFactor;mfMinDistance = mfMaxDistance / pRefKF->mvScaleFactors[nLevels - 1];mNormalVector = normal / n;}

}

地圖點的平均觀測距離是根據其參考關鍵幀計算的,那么參考關鍵幀KeyFrame* mpRefKF是如何指定的呢?

構造函數中,創建該地圖點的參考幀被設為參考關鍵幀.

若當前地圖點對參考關鍵幀的觀測被刪除(EraseObservation(KeyFrame* pKF)),則取第一個觀測到當前地圖點的關鍵幀做參考關鍵幀.

函數MapPoint::UpdateNormalAndDepth()的調用時機:

1 創建地圖點時調用UpdateNormalAndDepth()初始化其觀測信息.

pNewMP->AddObservation(pKF, i);

pKF->AddMapPoint(pNewMP, i);

pNewMP->ComputeDistinctiveDescriptors();

pNewMP->UpdateNormalAndDepth(); // 更新平均觀測方向和距離

mpMap->AddMapPoint(pNewMP);

-

地圖點對關鍵幀的觀測

mObservations更新時(跟蹤局部地圖添加或刪除對關鍵幀的觀測時、LocalMapping線程刪除冗余關鍵幀時或**LoopClosing線程閉環矯正**時),調用UpdateNormalAndDepth()初始化其觀測信息.

pMP->AddObservation(mpCurrentKeyFrame, i);

pMP->UpdateNormalAndDepth();

-

地圖點世界坐標

mWorldPos發生變化時(BA優化之后),調用UpdateNormalAndDepth()初始化其觀測信息.pMP->SetWorldPos(cvCorrectedP3Dw); pMP->UpdateNormalAndDepth();總結成一句話: 只要地圖點本身或關鍵幀對該地圖點的觀測發生變化,就應該調用函數

MapPoint::UpdateNormalAndDepth()更新其觀測尺度和方向信息.

?3.4 特征描述子

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

cv::Mat mDescriptor | protected | 當前關鍵點的特征描述子(所有描述子的中位數) |

cv::Mat GetDescriptor() | public | mDescriptor的get方法 |

void ComputeDistinctiveDescriptors() | public | 計算mDescriptor |

一個地圖點在不同關鍵幀中對應不同的特征點和描述子,其特征描述子mDescriptor是其在所有觀測關鍵幀中描述子的中位數(準確地說,該描述子與其他所有描述子的中值距離最小).

特征描述子的更新時機:

一旦某地圖點對關鍵幀的觀測mObservations發生改變,就調用函數MapPoint::ComputeDistinctiveDescriptors()更新該地圖點的特征描述子.

特征描述子的用途:

在函數ORBmatcher::SearchByProjection()和ORBmatcher::Fuse()中,通過比較地圖點的特征描述子與圖片特征點描述子,實現將地圖點與圖像特征點的匹配(3D-2D匹配).

3.5 地圖點的刪除與替換

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

bool mbBad | protected | 壞點標記 |

bool isBad() | public | 查詢當前地圖點是否被刪除(本質上就是查詢mbBad) |

void SetBadFlag() | public | 刪除當前地圖點 |

MapPoint* mpReplaced | protected | 用來替換當前地圖點的新地圖點 |

void Replace(MapPoint *pMP) | public | 使用地圖點pMP替換當前地圖點 |

3.6 地圖點的刪除:?SetBadFlag()

變量mbBad用來表征當前地圖點是否被刪除.

刪除地圖點的各成員變量是一個較耗時的過程,因此函數SetBadFlag()刪除關鍵點時采取先標記再清除的方式,具體的刪除過程分為以下兩步:

先將壞點標記mbBad置為true,邏輯上刪除該地圖點.(地圖點的社會性死亡)

再依次清空當前地圖點的各成員變量,物理上刪除該地圖點.(地圖點的肉體死亡)

這樣只有在設置壞點標記mbBad時需要加鎖,之后的操作就不需要加鎖了.

void MapPoint::SetBadFlag() {map<KeyFrame *, size_t> obs;{unique_lock<mutex> lock1(mMutexFeatures);unique_lock<mutex> lock2(mMutexPos);mbBad = true; // 標記mbBad,邏輯上刪除當前地圖點obs = mObservations;mObservations.clear();}// 刪除關鍵幀對當前地圖點的觀測for (KeyFrame *pKF : obs.begin()) {pKF->EraseMapPointMatch(mit->second);}

?// 在地圖類上注冊刪除當前地圖點,這里會發生內存泄漏mpMap->EraseMapPoint(this);

}

成員變量mbBad表示當前地圖點邏輯上是否被刪除,在后面用到地圖點的地方,都要通過isBad()函數確認當前地圖點沒有被刪除,再接著進行其它操作.

int KeyFrame::TrackedMapPoints(const int &minObs) {// ...for (int i = 0; i < N; i++) {MapPoint *pMP = mvpMapPoints[i];if (pMP && !pMP->isBad()) { // 依次檢查該地圖點物理上和邏輯上是否刪除,若刪除了就不對其操作// ...}}// ...

}

3.7 地圖點的替換:?Replace()

函數Replace(MapPoint* pMP)將當前地圖點的成員變量疊加到新地圖點pMP上.

void MapPoint::Replace(MapPoint *pMP) {// 如果是同一地圖點則跳過if (pMP->mnId == this->mnId)return;

?// step1. 邏輯上刪除當前地圖點int nvisible, nfound;map<KeyFrame *, size_t> obs;{unique_lock<mutex> lock1(mMutexFeatures);unique_lock<mutex> lock2(mMutexPos);obs = mObservations;mObservations.clear();mbBad = true;nvisible = mnVisible;nfound = mnFound;mpReplaced = pMP;}

?// step2. 將當地圖點的數據疊加到新地圖點上for (map<KeyFrame *, size_t>::iterator mit = obs.begin(), mend = obs.end(); mit != mend; mit++) {KeyFrame *pKF = mit->first;if (!pMP->IsInKeyFrame(pKF)) {pKF->ReplaceMapPointMatch(mit->second, pMP);pMP->AddObservation(pKF, mit->second);} else {pKF->EraseMapPointMatch(mit->second);}}

?pMP->IncreaseFound(nfound);pMP->IncreaseVisible(nvisible);pMP->ComputeDistinctiveDescriptors();

?// step3. 刪除當前地圖點mpMap->EraseMapPoint(this);

}

3.8?MapPoint類的用途

MapPoint的生命周期

針對MapPoint的生命周期,我們關心以下3個問題:

?創建MapPoint的時機:

Tracking線程中初始化過程(Tracking::MonocularInitialization()和Tracking::StereoInitialization())

Tracking線程中創建新的關鍵幀(Tracking::CreateNewKeyFrame())

Tracking線程中恒速運動模型跟蹤(Tracking::TrackWithMotionModel())也會產生臨時地圖點,但這些臨時地圖點在跟蹤成功后會被馬上刪除(那跟蹤失敗怎么辦?跟蹤失敗的話不會產生關鍵幀,這些地圖點也不會被注冊進地圖).

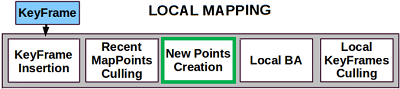

LocalMapping線程中創建新地圖點的步驟(LocalMapping::CreateNewMapPoints())會將當前關鍵幀與前一關鍵幀進行匹配,生成新地圖點.

刪除MapPoint的時機:

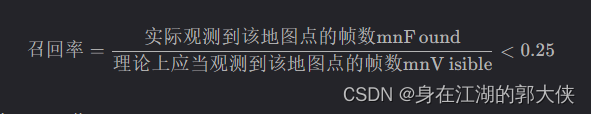

LocalMapping線程中刪除惡劣地圖點的步驟(LocalMapping::MapPointCulling()).

刪除關鍵幀的函數KeyFrame::SetBadFlag()會調用函數MapPoint::EraseObservation()刪除地圖點對關鍵幀的觀測,若地圖點對關鍵幀的觀測少于2,則地圖點無法被三角化,就刪除該地圖點.

替換MapPoint的時機:

LoopClosing線程中閉環矯正(LoopClosing::CorrectLoop())時當前關鍵幀和閉環關鍵幀上的地圖點發生沖突時,會使用閉環關鍵幀的地圖點替換當前關鍵幀的地圖點.

LoopClosing線程中閉環矯正函數LoopClosing::CorrectLoop()會調用LoopClosing::SearchAndFuse()將閉環關鍵幀的共視關鍵幀組中所有地圖點投影到當前關鍵幀的共視關鍵幀組中,發生沖突時就會替換.

4. ORB-SLAM2代碼詳解04_幀Frame

4.1 各成員函數/變量

4.1.1 相機相關信息

Frame類與相機相關的參數大部分設為static類型,整個系統內的所有Frame對象共享同一份相機參數.

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

mbInitialComputations | public static | 是否需要為Frame類的相機參數賦值 初始化為false,第一次為相機參數賦值后變為false |

float fx,?float fy?float cx,?float cy?float invfx,?float invfy | public static | 相機內參 |

cv::Mat mK | public | 相機內參矩陣 設為static是否更好? |

float mb | public | 相機基線,相機雙目間的距離 |

float mbf | public | 相機基線與焦距的乘積 |

這些參數首先由Tracking對象從配置文件TUM1.yaml內讀入,再傳給Frame類的構造函數,第一次調用Frame的構造函數時為這些成員變量賦值.

Tracking::Tracking(const string &strSettingPath, ...) {

?// 從配置文件中讀取相機參數并構造內參矩陣cv::FileStorage fSettings(strSettingPath, cv::FileStorage::READ);float fx = fSettings["Camera.fx"];float fy = fSettings["Camera.fy"];float cx = fSettings["Camera.cx"];float cy = fSettings["Camera.cy"];

?cv::Mat K = cv::Mat::eye(3, 3, CV_32F);K.at<float>(0, 0) = fx;K.at<float>(1, 1) = fy;K.at<float>(0, 2) = cx;K.at<float>(1, 2) = cy;K.copyTo(mK);

?// ...

}

?

// 每傳來一幀圖像,就調用一次該函數

cv::Mat Tracking::GrabImageStereo(..., const cv::Mat &imRectLeft, const cv::Mat &imRectRight, const double ×tamp) {mCurrentFrame = Frame(mImGray, mK, mDistCoef, mbf, mThDepth);

?Track();

?// ...

}

?

// Frame構造函數

Frame::Frame(cv::Mat &K, cv::Mat &distCoef, const float &bf, const float &thDepth): mK(K.clone()), mDistCoef(distCoef.clone()), mbf(bf), mThDepth(thDepth) {// ...// 第一次調用Frame()構造函數時為所有static變量賦值if (mbInitialComputations) {fx = K.at<float>(0, 0);fy = K.at<float>(1, 1);cx = K.at<float>(0, 2);cy = K.at<float>(1, 2);invfx = 1.0f / fx;invfy = 1.0f / fy;// ...mbInitialComputations = false; // 賦值完畢后將mbInitialComputations復位}

?mb = mbf / fx;

}

4.2 特征點提取

在Frame類構造函數中調用成員變量mpORBextractorLeft和mpORBextractorRight的()運算符進行特征點提取.

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

ORBextractor* mpORBextractorLeft?ORBextractor* mpORBextractorRight | public | 左右目圖像的特征點提取器 |

cv::Mat mDescriptors?cv::Mat mDescriptorsRight | public | 左右目圖像特征點描述子 |

std::vector mvKeys?std::vector mvKeysRight | public | 畸變矯正前的左/右目特征點 |

std::vector mvKeysUn | public | 畸變矯正后的左目特征點 |

std::vector mvuRight | public | 左目特征點在右目中匹配特征點的橫坐標 (左右目匹配特征點的縱坐標相同) |

std::vector mvDepth | public | 特征點深度 |

float mThDepth | public | 判斷單目特征點和雙目特征點的閾值 深度低于該值的特征點被認為是雙目特征點 深度低于該值得特征點被認為是單目特征點 |

mvKeys、 mvKeysUn、 mvuRight、 mvDepth的坐標索引是對應的,也就是說對于第i個圖像特征點:

其畸變矯正前的左目特征點是mvKeys[i].

其畸變矯正后的左目特征點是mvKeysUn[i].

其在右目圖片中對應特征點的橫坐標為mvuRight[i],縱坐標與mvKeys[i]的縱坐標相同.

特征點的深度是mvDepth[i].

對于單目特征點(單目相機輸入的特征點或沒有找到右目匹配的左目圖像特征點),其mvuRight和mvDepth均為-1.

4.2.1 特征點提取:?ExtractORB()

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

void ExtractORB(int flag, const cv::Mat &im) | public | 進行ORB特征提取 |

void Frame::ExtractORB(int flag, const cv::Mat &im) {if (flag == 0) // flag==0, 表示對左圖提取ORB特征點(*mpORBextractorLeft)(im, cv::Mat(), mvKeys, mDescriptors);else // flag==1, 表示對右圖提取ORB特征點(*mpORBextractorRight)(im, cv::Mat(), mvKeysRight, mDescriptorsRight);

}

4.3 ORB-SLAM2對雙目/RGBD特征點的預處理

雙目/RGBD相機中可以得到特征點的立體信息,包括右目特征點信息(mvuRight)、特征點深度信息(mvDepth)

對于雙目相機,通過雙目特征點匹配關系計算特征點的深度值.

對于RGBD相機,根據特征點深度構造虛擬的右目圖像特征點.

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

void ComputeStereoMatches() | public | 雙目圖像特征點匹配,用于雙目相機輸入圖像預處理 |

void ComputeStereoFromRGBD(const cv::Mat &imDepth) | public | 根據深度信息構造虛擬右目圖像,用于RGBD相機輸入圖像預處理 |

cv::Mat UnprojectStereo(const int &i) | public | 根據深度信息將第i個特征點反投影成MapPoint |

通過這種預處理,在后面SLAM系統的其他部分中不再區分雙目特征點和RGBD特征點,它們以雙目特征點的形式被處理.(僅通過判斷mvuRight[idx]判斷某特征點是否有深度).

int ORBmatcher::SearchByProjection(Frame &F, const vector<MapPoint *> &vpMapPoints, const float th) {// ...for (size_t idx : vIndices) {if (F.mvuRight[idx] > 0) { // 通過判斷 mvuRight[idx] 判斷該特征點是否有深度// 針對有深度的特征點特殊處理} else {// 針對單目特征點的特殊處理}}// ...

}

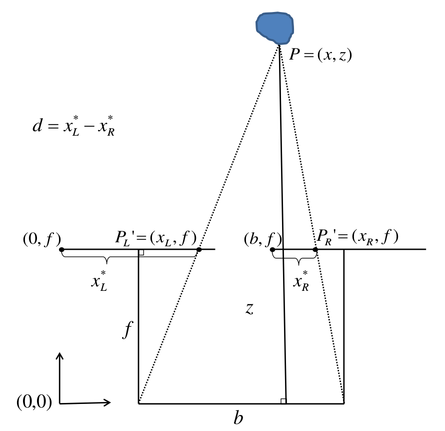

4.4 雙目視差公式

觀測距離,基線,焦距,視差,根據三角形相似性:

?

得到:

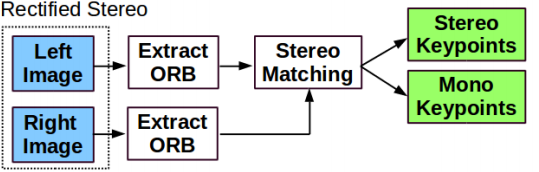

4.5 雙目特征點的處理:雙目圖像特征點匹配:?ComputeStereoMatches()

?稀疏立體匹配原理

函數ComputeStereoMatches()

兩幀圖像稀疏立體匹配

*輸入:兩幀立體矯正后的圖像對應的orb特征點集

*過程:

1.行特征點統計

2.粗匹配

3.精確匹配SAD

4.亞像素精度優化

5.最有視差值/深度選擇

6.刪除離缺點(outliers)

*輸出:稀疏特征點視差圖/深度圖和匹配結果

雙目相機分別提取到左右目特征點后對特征點進行雙目匹配,并通過雙目視差估計特征點深度.雙目特征點匹配步驟:

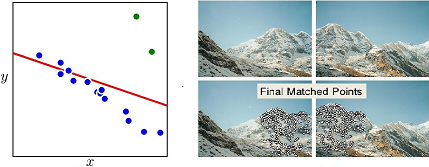

粗匹配: 根據特征點描述子距離和金字塔層級判斷匹配.粗匹配關系是按行尋找的,對于左目圖像中每個特征點,在右目圖像對應行上尋找匹配特征點.

精匹配: 根據特征點周圍窗口內容相似度判斷匹配.

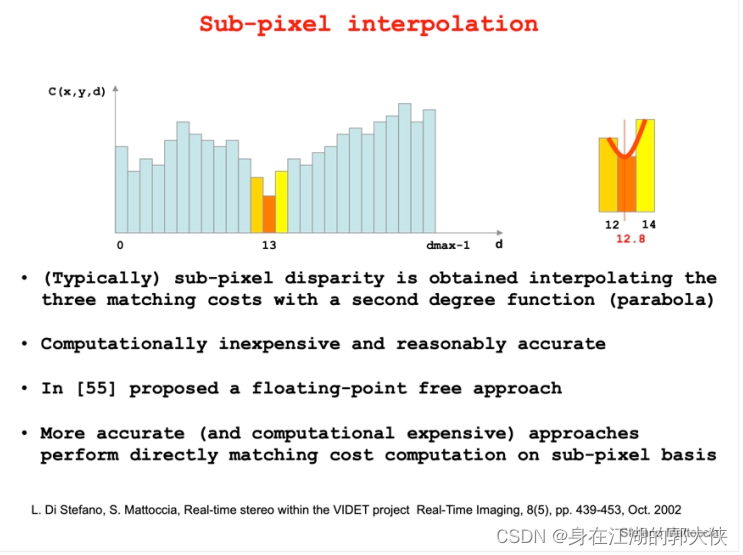

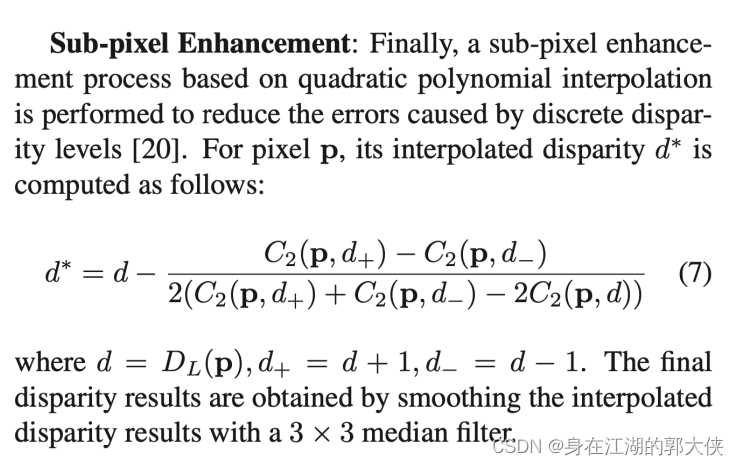

亞像素插值: 將特征點相似度與匹配坐標之間擬合成二次曲線,尋找最佳匹配位置(得到的是一個小數).

記錄右目匹配mvuRight和深度mvDepth信息.

離群點篩選: 以平均相似度的2.1倍為標準,篩選離群點.

?亞像素插值

?

void Frame::ComputeStereoMatches()

{/*兩幀圖像稀疏立體匹配(即:ORB特征點匹配,非逐像素的密集匹配,但依然滿足行對齊)* 輸入:兩幀立體矯正后的圖像img_left 和 img_right 對應的orb特征點集* 過程:1. 行特征點統計. 統計img_right每一行上的ORB特征點集,便于使用立體匹配思路(行搜索/極線搜索)進行同名點搜索, 避免逐像素的判斷.2. 粗匹配. 根據步驟1的結果,對img_left第i行的orb特征點pi,在img_right的第i行上的orb特征點集中搜索相似orb特征點, 得到qi3. 精確匹配. 以點qi為中心,半徑為r的范圍內,進行塊匹配(歸一化SAD),進一步優化匹配結果4. 亞像素精度優化. 步驟3得到的視差為uchar/int類型精度,并不一定是真實視差,通過亞像素差值(拋物線插值)獲取float精度的真實視差5. 最優視差值/深度選擇. 通過勝者為王算法(WTA)獲取最佳匹配點。6. 刪除離群點(outliers). 塊匹配相似度閾值判斷,歸一化sad最小,并不代表就一定是正確匹配,比如光照變化、弱紋理等會造成誤匹配* 輸出:稀疏特征點視差圖/深度圖(亞像素精度)mvDepth 匹配結果 mvuRight*/// 為匹配結果預先分配內存,數據類型為float型// mvuRight存儲右圖匹配點索引// mvDepth存儲特征點的深度信息mvuRight = vector<float>(N,-1.0f);mvDepth = vector<float>(N,-1.0f);// orb特征相似度閾值 -> mean ~= (max + min) / 2const int thOrbDist = (ORBmatcher::TH_HIGH+ORBmatcher::TH_LOW)/2;// 金字塔底層(0層)圖像高 nRowsconst int nRows = mpORBextractorLeft->mvImagePyramid[0].rows;// 二維vector存儲每一行的orb特征點的列坐標的索引,為什么是vector,因為每一行的特征點有可能不一樣,例如// vRowIndices[0] = [1,2,5,8, 11] 第1行有5個特征點,他們的列號(即x坐標)分別是1,2,5,8,11// vRowIndices[1] = [2,6,7,9, 13, 17, 20] 第2行有7個特征點.etcvector<vector<size_t> > vRowIndices(nRows, vector<size_t>());for(int i=0; i<nRows; i++) vRowIndices[i].reserve(200);// 右圖特征點數量,N表示數量 r表示右圖,且不能被修改const int Nr = mvKeysRight.size();// Step 1. 行特征點統計。 考慮用圖像金字塔尺度作為偏移,左圖中對應右圖的一個特征點可能存在于多行,而非唯一的一行for(int iR = 0; iR < Nr; iR++) {// 獲取特征點ir的y坐標,即行號const cv::KeyPoint &kp = mvKeysRight[iR];const float &kpY = kp.pt.y;// 計算特征點ir在行方向上,可能的偏移范圍r,即可能的行號為[kpY + r, kpY -r]// 2 表示在全尺寸(scale = 1)的情況下,假設有2個像素的偏移,隨著尺度變化,r也跟著變化const float r = 2.0f * mvScaleFactors[mvKeysRight[iR].octave];const int maxr = ceil(kpY + r);const int minr = floor(kpY - r);// 將特征點ir保證在可能的行號中for(int yi=minr;yi<=maxr;yi++)vRowIndices[yi].push_back(iR);}// 下面是 粗匹配 + 精匹配的過程// 對于立體矯正后的兩張圖,在列方向(x)存在最大視差maxd和最小視差mind// 也即是左圖中任何一點p,在右圖上的匹配點的范圍為應該是[p - maxd, p - mind], 而不需要遍歷每一行所有的像素// maxd = baseline * length_focal / minZ// mind = baseline * length_focal / maxZconst float minZ = mb;const float minD = 0; // 最小視差為0,對應無窮遠 const float maxD = mbf/minZ; // 最大視差對應的距離是相機的基線// 保存sad塊匹配相似度和左圖特征點索引vector<pair<int, int> > vDistIdx;vDistIdx.reserve(N);// 為左圖每一個特征點il,在右圖搜索最相似的特征點irfor(int iL=0; iL<N; iL++) {const cv::KeyPoint &kpL = mvKeys[iL];const int &levelL = kpL.octave;const float &vL = kpL.pt.y;const float &uL = kpL.pt.x;// 獲取左圖特征點il所在行,以及在右圖對應行中可能的匹配點const vector<size_t> &vCandidates = vRowIndices[vL];if(vCandidates.empty()) continue;// 計算理論上的最佳搜索范圍const float minU = uL-maxD;const float maxU = uL-minD;// 最大搜索范圍小于0,說明無匹配點if(maxU<0) continue;// 初始化最佳相似度,用最大相似度,以及最佳匹配點索引int bestDist = ORBmatcher::TH_HIGH;size_t bestIdxR = 0;const cv::Mat &dL = mDescriptors.row(iL);// Step 2. 粗配準。左圖特征點il與右圖中的可能的匹配點進行逐個比較,得到最相似匹配點的描述子距離和索引for(size_t iC=0; iC<vCandidates.size(); iC++) {const size_t iR = vCandidates[iC];const cv::KeyPoint &kpR = mvKeysRight[iR];// 左圖特征點il與待匹配點ic的空間尺度差超過2,放棄if(kpR.octave<levelL-1 || kpR.octave>levelL+1)continue;// 使用列坐標(x)進行匹配,和stereomatch一樣const float &uR = kpR.pt.x;// 超出理論搜索范圍[minU, maxU],可能是誤匹配,放棄if(uR >= minU && uR <= maxU) {// 計算匹配點il和待匹配點ic的相似度distconst cv::Mat &dR = mDescriptorsRight.row(iR);const int dist = ORBmatcher::DescriptorDistance(dL,dR);//統計最小相似度及其對應的列坐標(x)if( dist<bestDist ) {bestDist = dist;bestIdxR = iR;}}}// Step 3. 圖像塊滑動窗口用SAD(Sum of absolute differences,差的絕對和)實現精確匹配. if(bestDist<thOrbDist) {// 如果剛才匹配過程中的最佳描述子距離小于給定的閾值// 計算右圖特征點x坐標和對應的金字塔尺度const float uR0 = mvKeysRight[bestIdxR].pt.x;const float scaleFactor = mvInvScaleFactors[kpL.octave];// 尺度縮放后的左右圖特征點坐標const float scaleduL = round(kpL.pt.x*scaleFactor); const float scaledvL = round(kpL.pt.y*scaleFactor);const float scaleduR0 = round(uR0*scaleFactor);// 滑動窗口搜索, 類似模版卷積或濾波// w表示sad相似度的窗口半徑const int w = 5;// 提取左圖中,以特征點(scaleduL,scaledvL)為中心, 半徑為w的圖像塊patchcv::Mat IL = mpORBextractorLeft->mvImagePyramid[kpL.octave].rowRange(scaledvL-w,scaledvL+w+1).colRange(scaleduL-w,scaleduL+w+1);IL.convertTo(IL,CV_32F);// 圖像塊均值歸一化,降低亮度變化對相似度計算的影響IL = IL - IL.at<float>(w,w) * cv::Mat::ones(IL.rows,IL.cols,CV_32F);//初始化最佳相似度int bestDist = INT_MAX;// 通過滑動窗口搜索優化,得到的列坐標偏移量int bestincR = 0;//滑動窗口的滑動范圍為(-L, L)const int L = 5;// 初始化存儲圖像塊相似度vector<float> vDists;vDists.resize(2*L+1); // 計算滑動窗口滑動范圍的邊界,因為是塊匹配,還要算上圖像塊的尺寸// 列方向起點 iniu = r0 - 最大窗口滑動范圍 - 圖像塊尺寸// 列方向終點 eniu = r0 + 最大窗口滑動范圍 + 圖像塊尺寸 + 1// 此次 + 1 和下面的提取圖像塊是列坐標+1是一樣的,保證提取的圖像塊的寬是2 * w + 1// ! 源碼: const float iniu = scaleduR0+L-w; 錯誤// scaleduR0:右圖特征點x坐標const float iniu = scaleduR0-L-w;const float endu = scaleduR0+L+w+1;// 判斷搜索是否越界if(iniu<0 || endu >= mpORBextractorRight->mvImagePyramid[kpL.octave].cols)continue;// 在搜索范圍內從左到右滑動,并計算圖像塊相似度for(int incR=-L; incR<=+L; incR++) {// 提取右圖中,以特征點(scaleduL,scaledvL)為中心, 半徑為w的圖像快patchcv::Mat IR = mpORBextractorRight->mvImagePyramid[kpL.octave].rowRange(scaledvL-w,scaledvL+w+1).colRange(scaleduR0+incR-w,scaleduR0+incR+w+1);IR.convertTo(IR,CV_32F);// 圖像塊均值歸一化,降低亮度變化對相似度計算的影響IR = IR - IR.at<float>(w,w) * cv::Mat::ones(IR.rows,IR.cols,CV_32F);// sad 計算,值越小越相似float dist = cv::norm(IL,IR,cv::NORM_L1);// 統計最小sad和偏移量if(dist<bestDist) {bestDist = dist;bestincR = incR;}//L+incR 為refine后的匹配點列坐標(x)vDists[L+incR] = dist; }// 搜索窗口越界判斷if(bestincR==-L || bestincR==L)continue;// Step 4. 亞像素插值, 使用最佳匹配點及其左右相鄰點構成拋物線來得到最小sad的亞像素坐標// 使用3點擬合拋物線的方式,用極小值代替之前計算的最優是差值// \ / <- 由視差為14,15,16的相似度擬合的拋物線// . .(16)// .14 .(15) <- int/uchar最佳視差值// . // (14.5)<- 真實的視差值// deltaR = 15.5 - 16 = -0.5// 公式參考opencv sgbm源碼中的亞像素插值公式// 或論文<<On Building an Accurate Stereo Matching System on Graphics Hardware>> 公式7const float dist1 = vDists[L+bestincR-1]; const float dist2 = vDists[L+bestincR];const float dist3 = vDists[L+bestincR+1];const float deltaR = (dist1-dist3)/(2.0f*(dist1+dist3-2.0f*dist2));// 亞像素精度的修正量應該是在[-1,1]之間,否則就是誤匹配if(deltaR<-1 || deltaR>1)continue;// 根據亞像素精度偏移量delta調整最佳匹配索引float bestuR = mvScaleFactors[kpL.octave]*((float)scaleduR0+(float)bestincR+deltaR);float disparity = (uL-bestuR);if(disparity>=minD && disparity<maxD) {// 如果存在負視差,則約束為0.01if( disparity <=0 ) {disparity=0.01;bestuR = uL-0.01;}// 根據視差值計算深度信息// 保存最相似點的列坐標(x)信息// 保存歸一化sad最小相似度// Step 5. 最優視差值/深度選擇.mvDepth[iL]=mbf/disparity;mvuRight[iL] = bestuR;vDistIdx.push_back(pair<int,int>(bestDist,iL));} }}// Step 6. 刪除離群點(outliers)// 塊匹配相似度閾值判斷,歸一化sad最小,并不代表就一定是匹配的,比如光照變化、弱紋理、無紋理等同樣會造成誤匹配// 誤匹配判斷條件 norm_sad > 1.5 * 1.4 * mediansort(vDistIdx.begin(),vDistIdx.end());const float median = vDistIdx[vDistIdx.size()/2].first;const float thDist = 1.5f*1.4f*median;for(int i=vDistIdx.size()-1;i>=0;i--) {if(vDistIdx[i].first<thDist)break;else {// 誤匹配點置為-1,和初始化時保持一直,作為error codemvuRight[vDistIdx[i].second]=-1;mvDepth[vDistIdx[i].second]=-1;}}

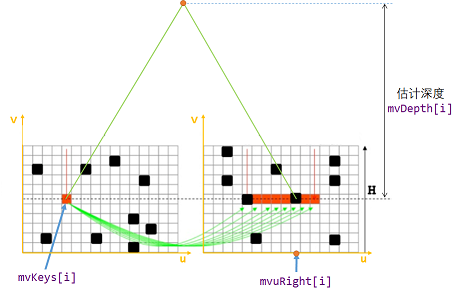

}4.6 RBGD特征點的處理: 根據深度信息構造虛擬右目圖像:?ComputeStereoFromRGBD()

對于RGB特征點,根據深度信息構造虛擬右目圖像?

//計算RGBD圖像的立體深度信息

void Frame::ComputeStereoFromRGBD(const cv::Mat &imDepth) //參數是深度圖像

{/** 主要步驟如下:.對于彩色圖像中的每一個特征點:<ul> */// mvDepth直接由depth圖像讀取`//這里是初始化這兩個存儲“右圖”匹配特征點橫坐標和存儲特征點深度值的vectormvuRight = vector<float>(N,-1);mvDepth = vector<float>(N,-1);//開始遍歷彩色圖像中的所有特征點for(int i=0; i<N; i++){/** <li> 從<b>未矯正的特征點</b>提供的坐標來讀取深度圖像拿到這個點的深度數據 </li> *///獲取校正前和校正后的特征點const cv::KeyPoint &kp = mvKeys[i];const cv::KeyPoint &kpU = mvKeysUn[i];//獲取其橫縱坐標,注意 NOTICE 是校正前的特征點的const float &v = kp.pt.y;const float &u = kp.pt.x;//從深度圖像中獲取這個特征點對應的深度點//NOTE 從這里看對深度圖像進行去畸變處理是沒有必要的,我們依舊可以直接通過未矯正的特征點的坐標來直接拿到深度數據const float d = imDepth.at<float>(v,u);///** <li> 如果獲取到的深度點合法(d>0), 那么就保存這個特征點的深度,并且計算出等效的\在假想的右圖中該特征點所匹配的特征點的橫坐標 </li>* \n 這個橫坐標的計算是 x-mbf/d* \n 其中的x使用的是<b>矯正后的</b>特征點的圖像坐標*/if(d>0){//那么就保存這個點的深度mvDepth[i] = d;//根據這個點的深度計算出等效的、在假想的右圖中的該特征點的橫坐標//TODO 話說為什么要計算這個嘞,計算出來之后有什么用?可能是為了保持計算一致mvuRight[i] = kpU.pt.x-mbf/d;}//如果獲取到的深度點合法}//開始遍歷彩色圖像中的所有特征點/** </ul> */

}4.7 畸變矯正:?UndistortKeyPoints()

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

cv::Mat mDistCoef | public | 相機的畸變矯正參數 |

std::vector mvKeys?std::vector mvKeysRight | public | 畸變矯正前的左/右目特征點 |

std::vector mvKeysUn | public | 畸變矯正后的左目特征點 |

void UndistortKeyPoints() | private | 對所有特征點進行畸變矯正 |

float mnMinX?float mnMaxX?float mnMinY?float mnMaxY | public | 畸變矯正后的圖像邊界 |

void ComputeImageBounds(const cv::Mat &imLeft) | private | 計算畸變矯正后的圖像邊界 |

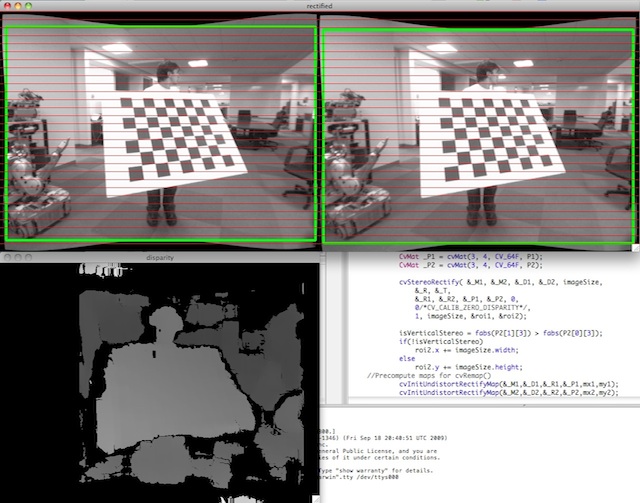

實際上,畸變矯正只對單目和RGBD相機輸入圖像有效,雙目相機的畸變矯正參數均為0,因為雙目相機數據集在發布之前預先做了雙目矯正.

- RGBD相機輸入配置文件

TUM1.yaml -

Camera.k1: 0.262383 Camera.k2: -0.953104 Camera.p1: -0.005358 Camera.p2: 0.002628 Camera.k3: 1.163314 ? #.... -

雙目相機輸入配置文件

EuRoC.yamlCamera.k1: 0.0 Camera.k2: 0.0 Camera.p1: 0.0 Camera.p2: 0.0 ? # ... -

單目相機輸入配置文件

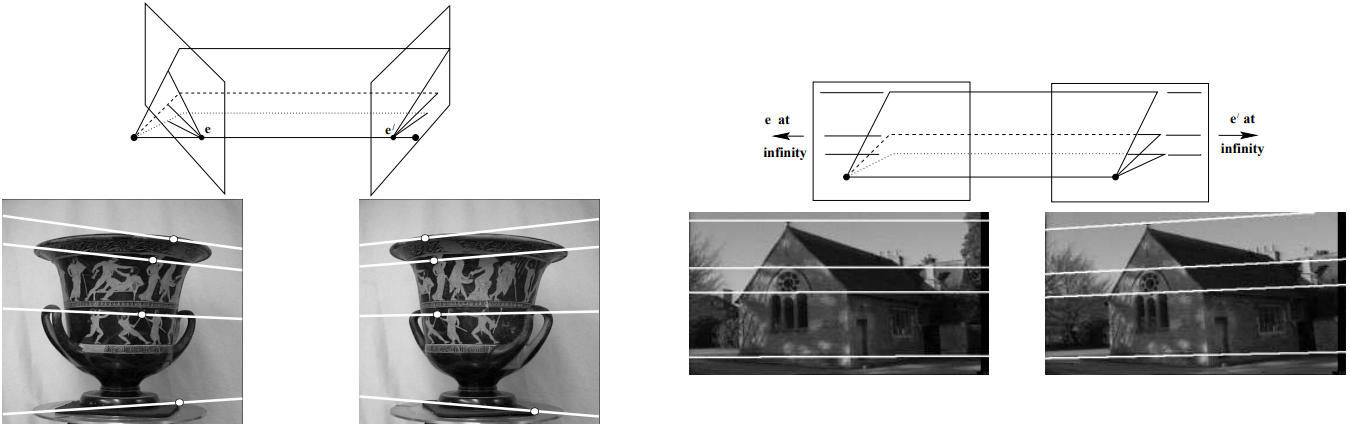

TUM1.yaml%YAML:1.0#-------------------------------------------------------------------------------------------- # Camera Parameters. Adjust them! #--------------------------------------------------------------------------------------------# Camera calibration and distortion parameters (OpenCV) Camera.fx: 517.306408 Camera.fy: 516.469215 Camera.cx: 318.643040 Camera.cy: 255.313989Camera.k1: 0.262383 Camera.k2: -0.953104 Camera.p1: -0.005358 Camera.p2: 0.002628 Camera.k3: 1.163314雙目矯正效果如下,雙目矯正將兩個相機的成像平面矯正到同一平面上.雙目矯正之后兩個相機的極線相互平行,極點在無窮遠處,這也是我們在函數

ComputeStereoMatches()中做極線搜索的理論基礎.

?

UndistortKeyPoints()函數和ComputeImageBounds()內調用了cv::undistortPoints()函數對特征點進行畸變矯正 -

void Frame::UndistortKeyPoints() {// Step 1 如果第一個畸變參數為0,不需要矯正。第一個畸變參數k1是最重要的,一般不為0,為0的話,說明畸變參數都是0//變量mDistCoef中存儲了opencv指定格式的去畸變參數,格式為:(k1,k2,p1,p2,k3)if(mDistCoef.at<float>(0)==0.0){mvKeysUn=mvKeys;return;}// Step 2 如果畸變參數不為0,用OpenCV函數進行畸變矯正// Fill matrix with points// N為提取的特征點數量,為滿足OpenCV函數輸入要求,將N個特征點保存在N*2的矩陣中cv::Mat mat(N,2,CV_32F);//遍歷每個特征點,并將它們的坐標保存到矩陣中for(int i=0; i<N; i++){//然后將這個特征點的橫縱坐標分別保存mat.at<float>(i,0)=mvKeys[i].pt.x;mat.at<float>(i,1)=mvKeys[i].pt.y;}// Undistort points// 函數reshape(int cn,int rows=0) 其中cn為更改后的通道數,rows=0表示這個行將保持原來的參數不變//為了能夠直接調用opencv的函數來去畸變,需要先將矩陣調整為2通道(對應坐標x,y) mat=mat.reshape(2);cv::undistortPoints( mat, //輸入的特征點坐標mat, //輸出的校正后的特征點坐標覆蓋原矩陣mK, //相機的內參數矩陣mDistCoef, //相機畸變參數矩陣cv::Mat(), //一個空矩陣,對應為函數原型中的RmK); //新內參數矩陣,對應為函數原型中的P//調整回只有一個通道,回歸我們正常的處理方式mat=mat.reshape(1);// Fill undistorted keypoint vector// Step 存儲校正后的特征點mvKeysUn.resize(N);//遍歷每一個特征點for(int i=0; i<N; i++){//根據索引獲取這個特征點//注意之所以這樣做而不是直接重新聲明一個特征點對象的目的是,能夠得到源特征點對象的其他屬性cv::KeyPoint kp = mvKeys[i];//讀取校正后的坐標并覆蓋老坐標kp.pt.x=mat.at<float>(i,0);kp.pt.y=mat.at<float>(i,1);mvKeysUn[i]=kp;} }/*** @brief 計算去畸變圖像的邊界* * @param[in] imLeft 需要計算邊界的圖像*/ void Frame::ComputeImageBounds(const cv::Mat &imLeft) {// 如果畸變參數不為0,用OpenCV函數進行畸變矯正if(mDistCoef.at<float>(0)!=0.0){// 保存矯正前的圖像四個邊界點坐標: (0,0) (cols,0) (0,rows) (cols,rows)cv::Mat mat(4,2,CV_32F);mat.at<float>(0,0)=0.0; //左上mat.at<float>(0,1)=0.0;mat.at<float>(1,0)=imLeft.cols; //右上mat.at<float>(1,1)=0.0;mat.at<float>(2,0)=0.0; //左下mat.at<float>(2,1)=imLeft.rows;mat.at<float>(3,0)=imLeft.cols; //右下mat.at<float>(3,1)=imLeft.rows;// Undistort corners// 和前面校正特征點一樣的操作,將這幾個邊界點作為輸入進行校正mat=mat.reshape(2);cv::undistortPoints(mat,mat,mK,mDistCoef,cv::Mat(),mK);mat=mat.reshape(1);//校正后的四個邊界點已經不能夠圍成一個嚴格的矩形,因此在這個四邊形的外側加邊框作為坐標的邊界mnMinX = min(mat.at<float>(0,0),mat.at<float>(2,0));//左上和左下橫坐標最小的mnMaxX = max(mat.at<float>(1,0),mat.at<float>(3,0));//右上和右下橫坐標最大的mnMinY = min(mat.at<float>(0,1),mat.at<float>(1,1));//左上和右上縱坐標最小的mnMaxY = max(mat.at<float>(2,1),mat.at<float>(3,1));//左下和右下縱坐標最小的}else{// 如果畸變參數為0,就直接獲得圖像邊界mnMinX = 0.0f;mnMaxX = imLeft.cols;mnMinY = 0.0f;mnMaxY = imLeft.rows;} }4.8 特征點分配:?

AssignFeaturesToGrid() - 在對特征點進行預處理后,將特征點分配到

48行64列的網格中以加速匹配成員函數/變量 訪問控制 意義 FRAME_GRID_ROWS=48?FRAME_GRID_COLS=64#DEFINE宏網格行數/列數 float mfGridElementWidthInv?float mfGridElementHeightInvpublic static?public static每個網格的寬度/高度 std::vector mGrid[FRAME_GRID_COLS][FRAME_GRID_ROWS]public每個網格內特征點編號列表 void AssignFeaturesToGrid()private將特征點分配到網格中 vector GetFeaturesInArea(float &x, float &y, float &r, int minLevel, int maxLevel)public獲取半徑為 r的圓域內的特征點編號列表成員變量std::vector mGrid[FRAME_GRID_COLS][FRAME_GRID_ROWS]是一個二維數組,數組中每個元素是對應網格的所有特征點索引列表.

static成員變量mfGridElementWidthInv、mfGridElementHeightInv表示網格寬度/高度,它們在第一次調用Frame構造函數時被計算賦值.

Frame::Frame(const cv::Mat &imLeft, const cv::Mat &imRight, const double &timeStamp, ORBextractor* extractorLeft, ORBextractor* extractorRight, ORBVocabulary* voc, cv::Mat &K, cv::Mat &distCoef, const float &bf, const float &thDepth):mpORBvocabulary(voc),mpORBextractorLeft(extractorLeft),mpORBextractorRight(extractorRight), mTimeStamp(timeStamp), mK(K.clone()),mDistCoef(distCoef.clone()), mbf(bf), mThDepth(thDepth),mpReferenceKF(static_cast<KeyFrame*>(NULL)) {// Step 1 幀的ID 自增mnId=nNextId++;// Step 2 計算圖像金字塔的參數 //獲取圖像金字塔的層數mnScaleLevels = mpORBextractorLeft->GetLevels();//這個是獲得層與層之前的縮放比mfScaleFactor = mpORBextractorLeft->GetScaleFactor();//計算上面縮放比的對數, NOTICE log=自然對數,log10=才是以10為基底的對數 mfLogScaleFactor = log(mfScaleFactor);//獲取每層圖像的縮放因子mvScaleFactors = mpORBextractorLeft->GetScaleFactors();//同樣獲取每層圖像縮放因子的倒數mvInvScaleFactors = mpORBextractorLeft->GetInverseScaleFactors();//高斯模糊的時候,使用的方差mvLevelSigma2 = mpORBextractorLeft->GetScaleSigmaSquares();//獲取sigma^2的倒數mvInvLevelSigma2 = mpORBextractorLeft->GetInverseScaleSigmaSquares();// ORB extraction// Step 3 對左目右目圖像提取ORB特征點, 第一個參數0-左圖, 1-右圖。為加速計算,同時開了兩個線程計算thread threadLeft(&Frame::ExtractORB, //該線程的主函數this, //當前幀對象的對象指針0, //表示是左圖圖像imLeft); //圖像數據//對右目圖像提取ORB特征,參數含義同上thread threadRight(&Frame::ExtractORB,this,1,imRight);//等待兩張圖像特征點提取過程完成threadLeft.join();threadRight.join();//mvKeys中保存的是左圖像中的特征點,這里是獲取左側圖像中特征點的個數N = mvKeys.size();//如果左圖像中沒有成功提取到特征點那么就返回,也意味這這一幀的圖像無法使用if(mvKeys.empty())return;// Step 4 用OpenCV的矯正函數、內參對提取到的特征點進行矯正// 實際上由于雙目輸入的圖像已經預先經過矯正,所以實際上并沒有對特征點進行任何處理操作UndistortKeyPoints();// Step 5 計算雙目間特征點的匹配,只有匹配成功的特征點會計算其深度,深度存放在 mvDepth // mvuRight中存儲的應該是左圖像中的點所匹配的在右圖像中的點的橫坐標(縱坐標相同)ComputeStereoMatches();// 初始化本幀的地圖點mvpMapPoints = vector<MapPoint*>(N,static_cast<MapPoint*>(NULL)); // 記錄地圖點是否為外點,初始化均為外點falsemvbOutlier = vector<bool>(N,false);// This is done only for the first Frame (or after a change in the calibration)// Step 5 計算去畸變后圖像邊界,將特征點分配到網格中。這個過程一般是在第一幀或者是相機標定參數發生變化之后進行if(mbInitialComputations){//計算去畸變后圖像的邊界ComputeImageBounds(imLeft);// 表示一個圖像像素相當于多少個圖像網格列(寬)mfGridElementWidthInv=static_cast<float>(FRAME_GRID_COLS)/static_cast<float>(mnMaxX-mnMinX);// 表示一個圖像像素相當于多少個圖像網格行(高)mfGridElementHeightInv=static_cast<float>(FRAME_GRID_ROWS)/static_cast<float>(mnMaxY-mnMinY);//給類的靜態成員變量復制fx = K.at<float>(0,0);fy = K.at<float>(1,1);cx = K.at<float>(0,2);cy = K.at<float>(1,2);// 猜測是因為這種除法計算需要的時間略長,所以這里直接存儲了這個中間計算結果invfx = 1.0f/fx;invfy = 1.0f/fy;//特殊的初始化過程完成,標志復位mbInitialComputations=false;}// 雙目相機基線長度mb = mbf/fx;// 將特征點分配到圖像網格中 AssignFeaturesToGrid(); }函數

AssignFeaturesToGrid()將特征點分配到網格中void Frame::AssignFeaturesToGrid() {// Step 1 給存儲特征點的網格數組 Frame::mGrid 預分配空間// ? 這里0.5 是為什么?節省空間?// FRAME_GRID_COLS = 64,FRAME_GRID_ROWS=48int nReserve = 0.5f*N/(FRAME_GRID_COLS*FRAME_GRID_ROWS);//開始對mGrid這個二維數組中的每一個vector元素遍歷并預分配空間for(unsigned int i=0; i<FRAME_GRID_COLS;i++)for (unsigned int j=0; j<FRAME_GRID_ROWS;j++)mGrid[i][j].reserve(nReserve);// Step 2 遍歷每個特征點,將每個特征點在mvKeysUn中的索引值放到對應的網格mGrid中for(int i=0;i<N;i++){//從類的成員變量中獲取已經去畸變后的特征點const cv::KeyPoint &kp = mvKeysUn[i];//存儲某個特征點所在網格的網格坐標,nGridPosX范圍:[0,FRAME_GRID_COLS], nGridPosY范圍:[0,FRAME_GRID_ROWS]int nGridPosX, nGridPosY;// 計算某個特征點所在網格的網格坐標,如果找到特征點所在的網格坐標,記錄在nGridPosX,nGridPosY里,返回true,沒找到返回falseif(PosInGrid(kp,nGridPosX,nGridPosY))//如果找到特征點所在網格坐標,將這個特征點的索引添加到對應網格的數組mGrid中mGrid[nGridPosX][nGridPosY].push_back(i);} }函數

vector GetFeaturesInArea(float &x, float &y, float &r, int minLevel, int maxLevel)獲取點(y,x)周圍半徑為r的圓域內所有特征點編號.

4.9 構造函數:?Frame()?

Frame()構造函數依次進行上面介紹的步驟:

/*** @brief 為RGBD相機準備的幀構造函數* * @param[in] imGray 對RGB圖像灰度化之后得到的灰度圖像* @param[in] imDepth 深度圖像* @param[in] timeStamp 時間戳* @param[in] extractor 特征點提取器句柄* @param[in] voc ORB特征點詞典的句柄* @param[in] K 相機的內參數矩陣* @param[in] distCoef 相機的去畸變參數* @param[in] bf baseline*bf* @param[in] thDepth 遠點和近點的深度區分閾值*/

Frame::Frame(const cv::Mat &imGray, const cv::Mat &imDepth, const double &timeStamp, ORBextractor* extractor,ORBVocabulary* voc, cv::Mat &K, cv::Mat &distCoef, const float &bf, const float &thDepth):mpORBvocabulary(voc),mpORBextractorLeft(extractor),mpORBextractorRight(static_cast<ORBextractor*>(NULL)),mTimeStamp(timeStamp), mK(K.clone()),mDistCoef(distCoef.clone()), mbf(bf), mThDepth(thDepth)

{// Step 1 幀的ID 自增mnId=nNextId++;// Step 2 計算圖像金字塔的參數 //獲取圖像金字塔的層數mnScaleLevels = mpORBextractorLeft->GetLevels();//獲取每層的縮放因子mfScaleFactor = mpORBextractorLeft->GetScaleFactor(); //計算每層縮放因子的自然對數mfLogScaleFactor = log(mfScaleFactor);//獲取各層圖像的縮放因子mvScaleFactors = mpORBextractorLeft->GetScaleFactors();//獲取各層圖像的縮放因子的倒數mvInvScaleFactors = mpORBextractorLeft->GetInverseScaleFactors();//TODO 也是獲取這個不知道有什么實際含義的sigma^2mvLevelSigma2 = mpORBextractorLeft->GetScaleSigmaSquares();//計算上面獲取的sigma^2的倒數mvInvLevelSigma2 = mpORBextractorLeft->GetInverseScaleSigmaSquares();/** 3. 提取彩色圖像(其實現在已經灰度化成為灰度圖像了)的特征點 \n Frame::ExtractORB() */// ORB extraction// Step 3 對圖像進行提取特征點, 第一個參數0-左圖, 1-右圖ExtractORB(0,imGray);//獲取特征點的個數N = mvKeys.size();//如果這一幀沒有能夠提取出特征點,那么就直接返回了if(mvKeys.empty())return;// Step 4 用OpenCV的矯正函數、內參對提取到的特征點進行矯正UndistortKeyPoints();// Step 5 獲取圖像的深度,并且根據這個深度推算其右圖中匹配的特征點的視差ComputeStereoFromRGBD(imDepth);// 初始化本幀的地圖點mvpMapPoints = vector<MapPoint*>(N,static_cast<MapPoint*>(NULL));// 記錄地圖點是否為外點,初始化均為外點falsemvbOutlier = vector<bool>(N,false);// This is done only for the first Frame (or after a change in the calibration)// Step 5 計算去畸變后圖像邊界,將特征點分配到網格中。這個過程一般是在第一幀或者是相機標定參數發生變化之后進行if(mbInitialComputations){//計算去畸變后圖像的邊界ComputeImageBounds(imGray);// 表示一個圖像像素相當于多少個圖像網格列(寬)mfGridElementWidthInv=static_cast<float>(FRAME_GRID_COLS)/static_cast<float>(mnMaxX-mnMinX);// 表示一個圖像像素相當于多少個圖像網格行(高)mfGridElementHeightInv=static_cast<float>(FRAME_GRID_ROWS)/static_cast<float>(mnMaxY-mnMinY);//給類的靜態成員變量復制fx = K.at<float>(0,0);fy = K.at<float>(1,1);cx = K.at<float>(0,2);cy = K.at<float>(1,2);// 猜測是因為這種除法計算需要的時間略長,所以這里直接存儲了這個中間計算結果invfx = 1.0f/fx;invfy = 1.0f/fy;//特殊的初始化過程完成,標志復位mbInitialComputations=false;}// 計算假想的基線長度 baseline= mbf/fx// 后面要對從RGBD相機輸入的特征點,結合相機基線長度,焦距,以及點的深度等信息來計算其在假想的"右側圖像"上的匹配點mb = mbf/fx;// 將特征點分配到圖像網格中 AssignFeaturesToGrid();

}

4.10?Frame類的用途

?Tracking類有兩個Frame類型的成員變量

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

Frame mCurrentFrame | public | 當前正在處理的幀 |

Frame mLastFrame | protected | 上一幀 |

?Tracking線程每收到一幀圖像,就調用函數Tracking::GrabImageMonocular()、Tracking::GrabImageStereo()或Tracking::GrabImageRGBD()創建一個Frame對象,賦值給mCurrentFrame

/*** @brief * 輸入左目RGB或RGBA圖像,輸出世界坐標系到該幀相機坐標系的變換矩陣* * @param[in] im 單目圖像* @param[in] timestamp 時間戳* @return cv::Mat * * Step 1 :將彩色圖像轉為灰度圖像* Step 2 :構造Frame* Step 3 :跟蹤*/

cv::Mat Tracking::GrabImageMonocular(const cv::Mat &im,const double ×tamp)

{mImGray = im;// Step 1 :將彩色圖像轉為灰度圖像//若圖片是3、4通道的,還需要轉化成灰度圖if(mImGray.channels()==3){if(mbRGB)cvtColor(mImGray,mImGray,CV_RGB2GRAY);elsecvtColor(mImGray,mImGray,CV_BGR2GRAY);}else if(mImGray.channels()==4){if(mbRGB)cvtColor(mImGray,mImGray,CV_RGBA2GRAY);elsecvtColor(mImGray,mImGray,CV_BGRA2GRAY);}// Step 2 :構造Frame//判斷該幀是不是初始化if(mState==NOT_INITIALIZED || mState==NO_IMAGES_YET) //沒有成功初始化的前一個狀態就是NO_IMAGES_YETmCurrentFrame = Frame(mImGray,timestamp,mpIniORBextractor, //初始化ORB特征點提取器會提取2倍的指定特征點數目mpORBVocabulary,mK,mDistCoef,mbf,mThDepth);elsemCurrentFrame = Frame(mImGray,timestamp,mpORBextractorLeft, //正常運行的時的ORB特征點提取器,提取指定數目特征點mpORBVocabulary,mK,mDistCoef,mbf,mThDepth);// Step 3 :跟蹤Track();//返回當前幀的位姿return mCurrentFrame.mTcw.clone();

}Track()函數跟蹤結束后,會將mCurrentFrame賦值給mLastFrame?

void Tracking::Track() {// 進行跟蹤// ...// 將當前幀記錄為上一幀mLastFrame = Frame(mCurrentFrame);// ...

}

?除了少數被選為KeyFrame的幀以外,大部分Frame對象的作用僅在于Tracking線程內追蹤當前幀位姿,不會對LocalMapping線程和LoopClosing線程產生任何影響,在mLastFrame和mCurrentFrame更新之后就被系統銷毀了.

5. ORB-SLAM2代碼詳解05_關鍵幀KeyFrame(對應文件KeyFrame.cc,KeyFrame.h)

5.1 各成員函數/變量

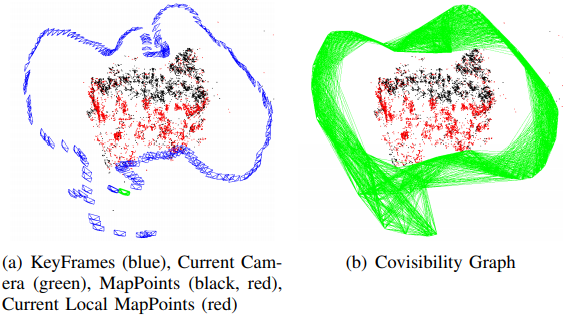

5.1.1 共視圖:?mConnectedKeyFrameWeights

能看到同一地圖點的兩關鍵幀之間存在共視關系,共視地圖點的數量被稱為權重.

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

std::map mConnectedKeyFrameWeights | protected | 當前關鍵幀的共視關鍵幀及權重 |

std::vector mvpOrderedConnectedKeyFrames | protected | 所有共視關鍵幀,按權重從大到小排序 |

std::vector mvOrderedWeights | protected | 所有共視權重,按從大到小排序 |

void UpdateConnections() | public | 基于當前關鍵幀對地圖點的觀測構造共視圖 |

void AddConnection(KeyFrame* pKF, int &weight) | public?應為private | 添加共視關鍵幀 |

void EraseConnection(KeyFrame* pKF) | public?應為private | 刪除共視關鍵幀 |

void UpdateBestCovisibles() | public?應為private | 基于共視圖信息修改對應變量 |

std::set GetConnectedKeyFrames() | public | get方法 |

std::vector GetVectorCovisibleKeyFrames() | public | get方法 |

std::vector GetBestCovisibilityKeyFrames(int &N) | public | get方法 |

std::vector GetCovisiblesByWeight(int &w) | public | get方法 |

int GetWeight(KeyFrame* pKF) | public | get方法 |

共視圖結構由3個成員變量維護:

mConnectedKeyFrameWeights是一個std::map,無序地保存當前關鍵幀的共視關鍵幀及權重.

mvpOrderedConnectedKeyFrames和mvOrderedWeights按權重降序分別保存當前關鍵幀的共視關鍵幀列表和權重列表.

5.1.2 基于對地圖點的觀測重新構造共視圖:?UpdateConnections()

這3個變量由函數KeyFrame::UpdateConnections()進行初始化和維護,基于當前關鍵幀看到的地圖點信息重新生成共視關鍵幀.

yFrame*> GetBestCovisibilityKeyFrames(int &N) | public | get方法 |

|---|---|---|

std::vector GetCovisiblesByWeight(int &w) | public | get方法 |

int GetWeight(KeyFrame* pKF) | public | get方法 |

void KeyFrame::UpdateConnections()

{// 關鍵幀-權重,權重為其它關鍵幀與當前關鍵幀共視地圖點的個數,也稱為共視程度map<KeyFrame*,int> KFcounter; vector<MapPoint*> vpMP;{// 獲得該關鍵幀的所有地圖點unique_lock<mutex> lockMPs(mMutexFeatures);vpMP = mvpMapPoints;}//For all map points in keyframe check in which other keyframes are they seen//Increase counter for those keyframes// Step 1 通過地圖點被關鍵幀觀測來間接統計關鍵幀之間的共視程度// 統計每一個地圖點都有多少關鍵幀與當前關鍵幀存在共視關系,統計結果放在KFcounterfor(vector<MapPoint*>::iterator vit=vpMP.begin(), vend=vpMP.end(); vit!=vend; vit++){MapPoint* pMP = *vit;if(!pMP)continue;if(pMP->isBad())continue;// 對于每一個地圖點,observations記錄了可以觀測到該地圖點的所有關鍵幀map<KeyFrame*,size_t> observations = pMP->GetObservations();for(map<KeyFrame*,size_t>::iterator mit=observations.begin(), mend=observations.end(); mit!=mend; mit++){// 除去自身,自己與自己不算共視if(mit->first->mnId==mnId)continue;// 這里的操作非常精彩!// map[key] = value,當要插入的鍵存在時,會覆蓋鍵對應的原來的值。如果鍵不存在,則添加一組鍵值對// mit->first 是地圖點看到的關鍵幀,同一個關鍵幀看到的地圖點會累加到該關鍵幀計數// 所以最后KFcounter 第一個參數表示某個關鍵幀,第2個參數表示該關鍵幀看到了多少當前幀的地圖點,也就是共視程度KFcounter[mit->first]++;}}// This should not happen// 沒有共視關系,直接退出 if(KFcounter.empty())return;// If the counter is greater than threshold add connection// In case no keyframe counter is over threshold add the one with maximum counterint nmax=0; // 記錄最高的共視程度KeyFrame* pKFmax=NULL;// 至少有15個共視地圖點才會添加共視關系int th = 15;// vPairs記錄與其它關鍵幀共視幀數大于th的關鍵幀// pair<int,KeyFrame*>將關鍵幀的權重寫在前面,關鍵幀寫在后面方便后面排序vector<pair<int,KeyFrame*> > vPairs;vPairs.reserve(KFcounter.size());// Step 2 找到對應權重最大的關鍵幀(共視程度最高的關鍵幀)for(map<KeyFrame*,int>::iterator mit=KFcounter.begin(), mend=KFcounter.end(); mit!=mend; mit++){if(mit->second>nmax){nmax=mit->second;pKFmax=mit->first;}// 建立共視關系至少需要大于等于th個共視地圖點if(mit->second>=th){// 對應權重需要大于閾值,對這些關鍵幀建立連接vPairs.push_back(make_pair(mit->second,mit->first));// 對方關鍵幀也要添加這個信息// 更新KFcounter中該關鍵幀的mConnectedKeyFrameWeights// 更新其它KeyFrame的mConnectedKeyFrameWeights,更新其它關鍵幀與當前幀的連接權重(mit->first)->AddConnection(this,mit->second);}}// Step 3 如果沒有超過閾值的權重,則對權重最大的關鍵幀建立連接if(vPairs.empty()){// 如果每個關鍵幀與它共視的關鍵幀的個數都少于th,// 那就只更新與其它關鍵幀共視程度最高的關鍵幀的mConnectedKeyFrameWeights// 這是對之前th這個閾值可能過高的一個補丁vPairs.push_back(make_pair(nmax,pKFmax));pKFmax->AddConnection(this,nmax);}// Step 4 對滿足共視程度的關鍵幀對更新連接關系及權重(從大到小)// vPairs里存的都是相互共視程度比較高的關鍵幀和共視權重,接下來由大到小進行排序sort(vPairs.begin(),vPairs.end()); // sort函數默認升序排列// 將排序后的結果分別組織成為兩種數據類型list<KeyFrame*> lKFs;list<int> lWs;for(size_t i=0; i<vPairs.size();i++){// push_front 后變成了從大到小順序lKFs.push_front(vPairs[i].second);lWs.push_front(vPairs[i].first);}{unique_lock<mutex> lockCon(mMutexConnections);// mspConnectedKeyFrames = spConnectedKeyFrames;// 更新當前幀與其它關鍵幀的連接權重// ?bug 這里直接賦值,會把小于閾值的共視關系也放入mConnectedKeyFrameWeights,會增加計算量// ?但后續主要用mvpOrderedConnectedKeyFrames來取共視幀,對結果沒影響mConnectedKeyFrameWeights = KFcounter;mvpOrderedConnectedKeyFrames = vector<KeyFrame*>(lKFs.begin(),lKFs.end());mvOrderedWeights = vector<int>(lWs.begin(), lWs.end());// Step 5 更新生成樹的連接if(mbFirstConnection && mnId!=0){// 初始化該關鍵幀的父關鍵幀為共視程度最高的那個關鍵幀mpParent = mvpOrderedConnectedKeyFrames.front();// 建立雙向連接關系,將當前關鍵幀作為其子關鍵幀mpParent->AddChild(this);mbFirstConnection = false;}}

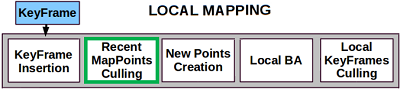

}只要關鍵幀與地圖點間的連接關系發生變化(包括關鍵幀創建和地圖點重新匹配關鍵幀特征點),函數KeyFrame::UpdateConnections()就會被調用.具體來說,函數KeyFrame::UpdateConnections()的調用時機包括:

Tracking線程中初始化函數Tracking::StereoInitialization()或Tracking::MonocularInitialization()函數創建關鍵幀后會調用KeyFrame::UpdateConnections()初始化共視圖信息.

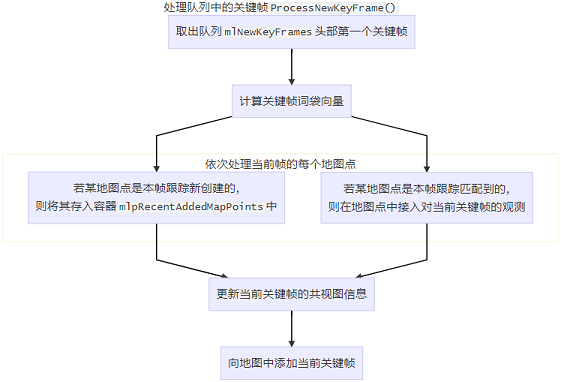

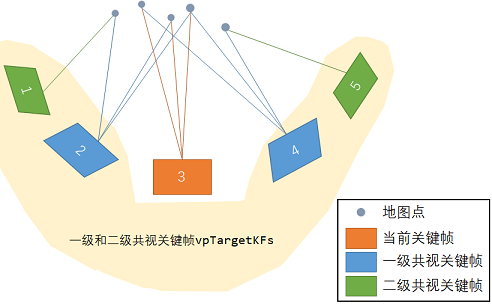

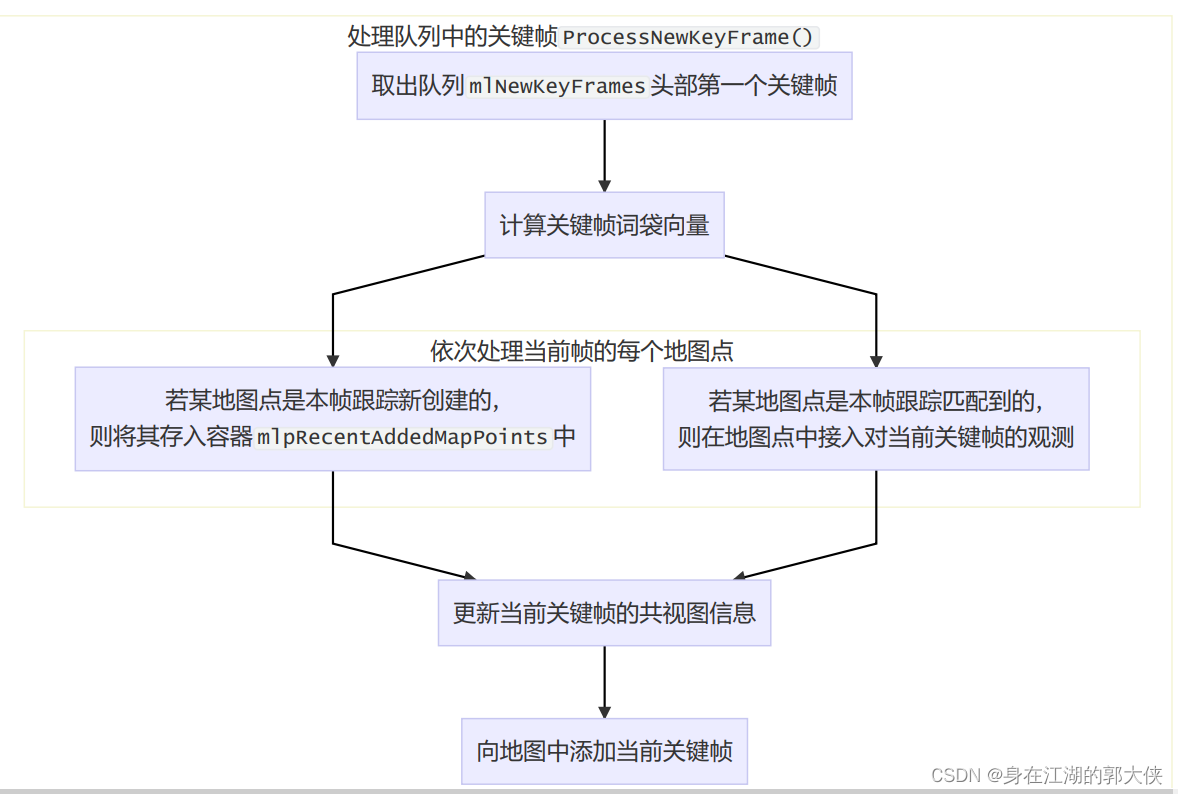

LocalMapping線程接受到新關鍵幀時會調用函數LocalMapping::ProcessNewKeyFrame()處理跟蹤過程中加入的地圖點,之后會調用KeyFrame::UpdateConnections()初始化共視圖信息.(實際上這里處理的是Tracking線程中函數Tracking::CreateNewKeyFrame()創建的關鍵幀)

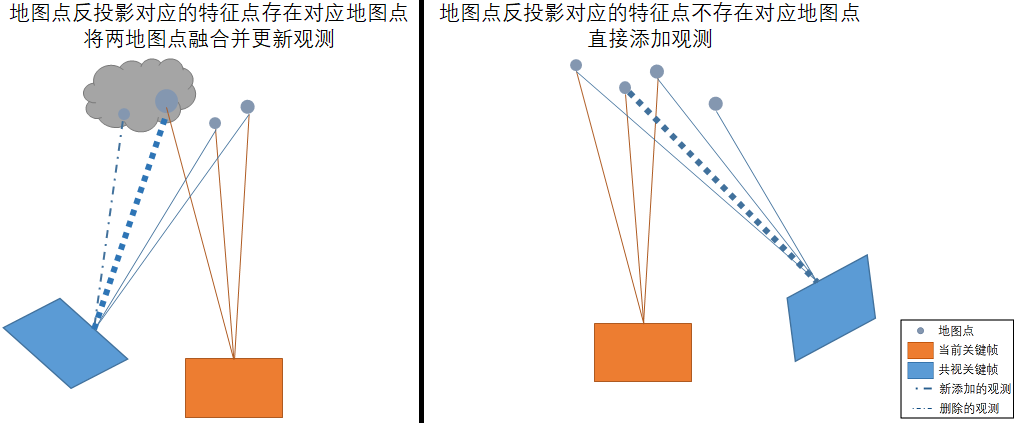

LocalMapping線程處理完畢緩沖隊列內所有關鍵幀后會調用LocalMapping::SearchInNeighbors()融合當前關鍵幀和共視關鍵幀間的重復地圖點,之后會調用KeyFrame::UpdateConnections()更新共視圖信息.

LoopClosing線程閉環矯正函數LoopClosing::CorrectLoop()會多次調用KeyFrame::UpdateConnections()更新共視圖信息.

函數AddConnection(KeyFrame* pKF, const int &weight)和EraseConnection(KeyFrame* pKF)先對變量mConnectedKeyFrameWeights進行修改,再調用函數UpdateBestCovisibles()修改變量mvpOrderedConnectedKeyFrames和mvOrderedWeights.

這3個函數都只在函數KeyFrame::UpdateConnections()內部被調用了,應該設為私有成員函數.

void KeyFrame::AddConnection(KeyFrame *pKF, const int &weight) {// step1. 修改變量mConnectedKeyFrameWeights{unique_lock<mutex> lock(mMutexConnections);

?if (!mConnectedKeyFrameWeights.count(pKF) || mConnectedKeyFrameWeights[pKF] != weight)mConnectedKeyFrameWeights[pKF] = weight;elsereturn;}// step2. 調用函數UpdateBestCovisibles()修改變量mvpOrderedConnectedKeyFrames和mvOrderedWeightsUpdateBestCovisibles();

}

?

?

void KeyFrame::EraseConnection(KeyFrame *pKF) {// step1. 修改變量mConnectedKeyFrameWeightsbool bUpdate = false;{unique_lock<mutex> lock(mMutexConnections);if (mConnectedKeyFrameWeights.count(pKF)) {mConnectedKeyFrameWeights.erase(pKF);bUpdate = true;}}

?// step2. 調用函數UpdateBestCovisibles()修改變量mvpOrderedConnectedKeyFrames和mvOrderedWeightsif (bUpdate)UpdateBestCovisibles();

}

?

void KeyFrame::UpdateBestCovisibles() { unique_lock<mutex> lock(mMutexConnections);// 取出所有關鍵幀進行排序,排序結果存入變量mvpOrderedConnectedKeyFrames和mvOrderedWeights中vector<pair<int, KeyFrame *> > vPairs;vPairs.reserve(mConnectedKeyFrameWeights.size());for (map<KeyFrame *, int>::iterator mit = mConnectedKeyFrameWeights.begin(), mend = mConnectedKeyFrameWeights.end(); mit != mend; mit++)vPairs.push_back(make_pair(mit->second, mit->first));

?sort(vPairs.begin(), vPairs.end());list<KeyFrame *> lKFs; list<int> lWs; for (size_t i = 0, iend = vPairs.size(); i < iend; i++) {lKFs.push_front(vPairs[i].second);lWs.push_front(vPairs[i].first);}

?mvpOrderedConnectedKeyFrames = vector<KeyFrame *>(lKFs.begin(), lKFs.end());mvOrderedWeights = vector<int>(lWs.begin(), lWs.end());

}

5.2 生成樹: mpParent、mspChildrens

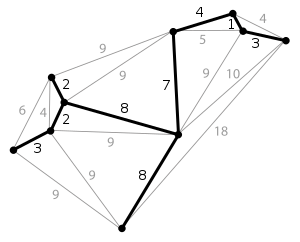

生成樹是一種稀疏連接,以最小的邊數保存圖中所有節點.對于含有N個節點的圖,只需構造一個N-1條邊的最小生成樹就可以將所有節點連接起來.

下圖表示含有一個10個節點,20條邊的稠密圖;粗黑線代表其最小生成樹,只需9條邊即可將所有節點連接起來.

?在ORB-SLAM2中,保存所有關鍵幀構成的最小生成樹(優先選擇權重大的邊作為生成樹的邊),在回環閉合時只需對最小生成樹做BA優化就能以最小代價優化所有關鍵幀和地圖點的位姿,相比于優化共視圖大大減少了計算量.(實際上并沒有對最小生成樹做BA優化,而是對包含生成樹的本質圖做BA優化)

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

bool mbFirstConnection | protected | 當前關鍵幀是否還未加入到生成樹 構造函數中初始化為true,加入生成樹后置為false |

KeyFrame* mpParent | protected | 當前關鍵幀在生成樹中的父節點 |

std::set mspChildrens | protected | 當前關鍵幀在生成樹中的子節點列表 |

KeyFrame* GetParent() | public | mpParent的get方法 |

void ChangeParent(KeyFrame* pKF) | public?應為private | mpParent的set方法 |

std::set GetChilds() | public | mspChildrens的get方法 |

void AddChild(KeyFrame* pKF) | public?應為private | 添加子節點,mspChildrens的set方法 |

void EraseChild(KeyFrame* pKF) | public?應為private | 刪除子節點,mspChildrens的set方法 |

bool hasChild(KeyFrame* pKF) | public | 判斷mspChildrens是否為空 |

生成樹結構由成員變量mpParent和mspChildrens維護.我們主要關注生成樹結構發生改變的時機.

關鍵幀增加到生成樹中的時機:

成功創建關鍵幀之后會調用函數KeyFrame::UpdateConnections(),該函數第一次被調用時會將該新關鍵幀加入到生成樹中.

新關鍵幀的父關鍵幀會被設為其共視程度最高的共視關鍵幀.

void KeyFrame::UpdateConnections() {// 更新共視圖信息// ...// 更新關鍵幀信息: 對于第一次加入生成樹的關鍵幀,取共視程度最高的關鍵幀為父關鍵幀// 該操作會改變當前關鍵幀的成員變量mpParent和父關鍵幀的成員變量mspChildrensunique_lock<mutex> lockCon(mMutexConnections);if (mbFirstConnection && mnId != 0) {mpParent = mvpOrderedConnectedKeyFrames.front();mpParent->AddChild(this);mbFirstConnection = false;}

}

共視圖的改變(除了刪除關鍵幀以外)不會引發生成樹的改變.

只有當某個關鍵幀刪除時,與其相連的生成樹結構在會發生改變.(因為生成樹是個單線聯系的結構,沒有冗余,一旦某關鍵幀刪除了就得更新樹結構才能保證所有關鍵幀依舊相連).生成樹結構改變的方式類似于最小生成樹算法中的加邊法,見后文對函數setbadflag()的分析.

?

5.3 關鍵幀的刪除?

| 成員函數/變量 | 訪問控制 | 意義 | 初值 |

|---|---|---|---|

bool mbBad | protected | 標記是壞幀 |

|

bool isBad() | public | mbBad的get方法 | |

void SetBadFlag() | public | 真的執行刪除 | |

bool mbNotErase | protected | 當前關鍵幀是否具有不被刪除的特權 | false |

bool mbToBeErased | protected | 當前關鍵幀是否曾被豁免過刪除 | false |

void SetNotErase() | public | mbNotErase的set方法 | |

void SetErase() | public |

?與MapPoint類似,函數KeyFrame::SetBadFlag()對KeyFrame的刪除過程也采取先標記再清除的方式: 先將壞幀標記mBad置為true,再依次處理其各成員變量.

?5.4 參與回環檢測的關鍵幀具有不被刪除的特權:?mbNotErase

參與回環檢測的關鍵幀具有不被刪除的特權,該特權由成員變量mbNotErase存儲,創建KeyFrame對象時該成員變量默認被初始化為false.

若某關鍵幀參與了回環檢測,LoopClosing線程就會就調用函數KeyFrame::SetNotErase()將該關鍵幀的成員變量mbNotErase設為true,標記該關鍵幀暫時不要被刪除.

void KeyFrame::SetNotErase() {unique_lock<mutex> lock(mMutexConnections);mbNotErase = true;

}

在刪除函數SetBadFlag()起始先根據成員變量mbNotErase判斷當前KeyFrame是否具有豁免刪除的特權.若當前KeyFrame的mbNotErase為true,則函數SetBadFlag()不能刪除當前KeyFrame,但會將其成員變量mbToBeErased置為true.

/*** @brief 真正地執行刪除關鍵幀的操作* 需要刪除的是該關鍵幀和其他所有幀、地圖點之間的連接關系* * mbNotErase作用:表示要刪除該關鍵幀及其連接關系但是這個關鍵幀有可能正在回環檢測或者計算sim3操作,這時候雖然這個關鍵幀冗余,但是卻不能刪除,* 僅設置mbNotErase為true,這時候調用setbadflag函數時,不會將這個關鍵幀刪除,只會把mbTobeErase變成true,代表這個關鍵幀可以刪除但不到時候,先記下來以后處理。* 在閉環線程里調用 SetErase()會根據mbToBeErased 來刪除之前可以刪除還沒刪除的幀。*/

void KeyFrame::SetBadFlag()

{ // Step 1 首先處理一下刪除不了的特殊情況{unique_lock<mutex> lock(mMutexConnections);// 第0關鍵幀不允許被刪除if(mnId==0)return;else if(mbNotErase){// mbNotErase表示不應該刪除,于是把mbToBeErased置為true,假裝已經刪除,其實沒有刪除mbToBeErased = true;return;}}// Step 2 遍歷所有和當前關鍵幀相連的關鍵幀,刪除他們與當前關鍵幀的聯系for(map<KeyFrame*,int>::iterator mit = mConnectedKeyFrameWeights.begin(), mend=mConnectedKeyFrameWeights.end(); mit!=mend; mit++)mit->first->EraseConnection(this); // 讓其它的關鍵幀刪除與自己的聯系// Step 3 遍歷每一個當前關鍵幀的地圖點,刪除每一個地圖點和當前關鍵幀的聯系for(size_t i=0; i<mvpMapPoints.size(); i++)if(mvpMapPoints[i])mvpMapPoints[i]->EraseObservation(this); {unique_lock<mutex> lock(mMutexConnections);unique_lock<mutex> lock1(mMutexFeatures);// 清空自己與其它關鍵幀之間的聯系mConnectedKeyFrameWeights.clear();mvpOrderedConnectedKeyFrames.clear();// Update Spanning Tree // Step 4 更新生成樹,主要是處理好父子關鍵幀,不然會造成整個關鍵幀維護的圖斷裂,或者混亂// 候選父關鍵幀set<KeyFrame*> sParentCandidates;// 將當前幀的父關鍵幀放入候選父關鍵幀sParentCandidates.insert(mpParent);// Assign at each iteration one children with a parent (the pair with highest covisibility weight)// Include that children as new parent candidate for the rest// 每迭代一次就為其中一個子關鍵幀尋找父關鍵幀(最高共視程度),找到父的子關鍵幀可以作為其他子關鍵幀的候選父關鍵幀while(!mspChildrens.empty()){bool bContinue = false;int max = -1;KeyFrame* pC;KeyFrame* pP;// Step 4.1 遍歷每一個子關鍵幀,讓它們更新它們指向的父關鍵幀for(set<KeyFrame*>::iterator sit=mspChildrens.begin(), send=mspChildrens.end(); sit!=send; sit++){KeyFrame* pKF = *sit;// 跳過無效的子關鍵幀if(pKF->isBad()) continue;// Check if a parent candidate is connected to the keyframe// Step 4.2 子關鍵幀遍歷每一個與它共視的關鍵幀 vector<KeyFrame*> vpConnected = pKF->GetVectorCovisibleKeyFrames();for(size_t i=0, iend=vpConnected.size(); i<iend; i++){// sParentCandidates 中剛開始存的是這里子關鍵幀的“爺爺”,也是當前關鍵幀的候選父關鍵幀for(set<KeyFrame*>::iterator spcit=sParentCandidates.begin(), spcend=sParentCandidates.end(); spcit!=spcend; spcit++){// Step 4.3 如果孩子和sParentCandidates中有共視,選擇共視最強的那個作為新的父if(vpConnected[i]->mnId == (*spcit)->mnId){int w = pKF->GetWeight(vpConnected[i]);// 尋找并更新權值最大的那個共視關系if(w>max){pC = pKF; //子關鍵幀pP = vpConnected[i]; //目前和子關鍵幀具有最大權值的關鍵幀(將來的父關鍵幀) max = w; //這個最大的權值bContinue = true; //說明子節點找到了可以作為其新父關鍵幀的幀}}}}}// Step 4.4 如果在上面的過程中找到了新的父節點// 下面代碼應該放到遍歷子關鍵幀循環中?// 回答:不需要!這里while循環還沒退出,會使用更新的sParentCandidatesif(bContinue){// 因為父節點死了,并且子節點找到了新的父節點,就把它更新為自己的父節點pC->ChangeParent(pP);// 因為子節點找到了新的父節點并更新了父節點,那么該子節點升級,作為其它子節點的備選父節點sParentCandidates.insert(pC);// 該子節點處理完畢,刪掉mspChildrens.erase(pC);}elsebreak;}// If a children has no covisibility links with any parent candidate, assign to the original parent of this KF// Step 4.5 如果還有子節點沒有找到新的父節點if(!mspChildrens.empty())for(set<KeyFrame*>::iterator sit=mspChildrens.begin(); sit!=mspChildrens.end(); sit++){// 直接把父節點的父節點作為自己的父節點 即對于這些子節點來說,他們的新的父節點其實就是自己的爺爺節點(*sit)->ChangeParent(mpParent);}mpParent->EraseChild(this);// mTcp 表示原父關鍵幀到當前關鍵幀的位姿變換,在保存位姿的時候使用mTcp = Tcw*mpParent->GetPoseInverse();// 標記當前關鍵幀已經掛了mbBad = true;} // 地圖和關鍵幀數據庫中刪除該關鍵幀mpMap->EraseKeyFrame(this);mpKeyFrameDB->erase(this);

}成員變量mbToBeErased標記當前KeyFrame是否被豁免過刪除特權.LoopClosing線程不再需要某關鍵幀時,會調用函數KeyFrame::SetErase()剝奪該關鍵幀不被刪除的特權,將成員變量mbNotErase復位為false;同時檢查成員變量mbToBeErased,若mbToBeErased為true就會調用函數KeyFrame::SetBadFlag()刪除該關鍵幀.

/*** @brief 刪除當前的這個關鍵幀,表示不進行回環檢測過程;由回環檢測線程調用* */

void KeyFrame::SetErase()

{{unique_lock<mutex> lock(mMutexConnections);// 如果當前關鍵幀和其他的關鍵幀沒有形成回環關系,那么就刪吧if(mspLoopEdges.empty()){mbNotErase = false;}}// mbToBeErased:刪除之前記錄的想要刪但時機不合適沒有刪除的幀if(mbToBeErased){SetBadFlag();}

}

5.5 刪除關鍵幀時維護共視圖和生成樹

函數SetBadFlag()在刪除關鍵幀的時維護其共視圖和生成樹結構.共視圖結構的維護比較簡單,這里主要關心如何維護生成樹的結構.

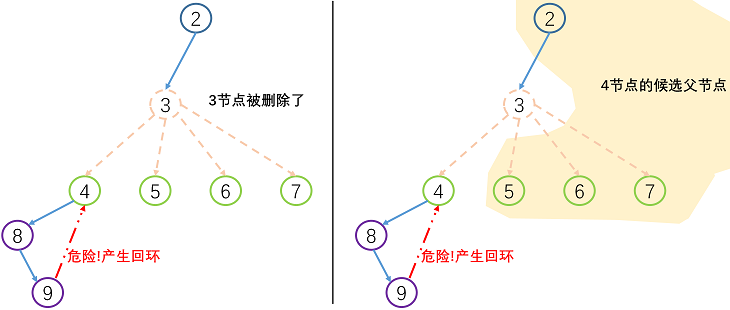

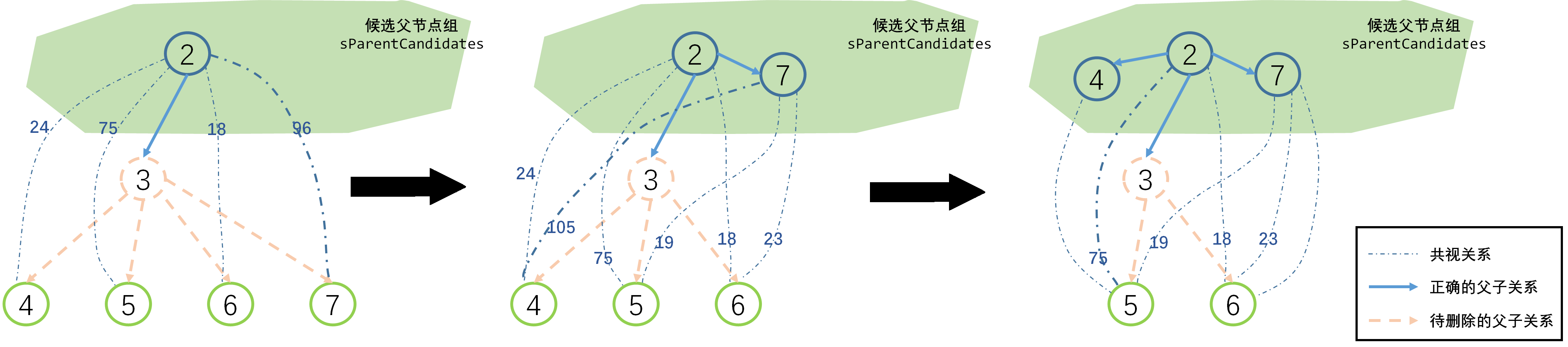

當一個關鍵幀被刪除時,其父關鍵幀和所有子關鍵幀的生成樹信息也會受到影響,需要為其所有子關鍵幀尋找新的父關鍵幀,如果父關鍵幀找的不好的話,就會產生回環,導致生成樹就斷開.

被刪除關鍵幀的子關鍵幀所有可能的父關鍵幀包括其兄弟關鍵幀和其被刪除關鍵幀的父關鍵幀.以下圖為例,關鍵幀4可能的父關鍵幀包括關鍵幀3、5、6和7.

采用類似于最小生成樹算法中的加邊法重新構建生成樹結構: 每次循環取權重最高的候選邊建立父子連接關系,并將新加入生成樹的子節點到加入候選父節點集合sParentCandidates中.

void KeyFrame::SetBadFlag() {// step1. 特殊情況:豁免 第一幀 和 具有mbNotErase特權的幀{unique_lock<mutex> lock(mMutexConnections);

?if (mnId == 0)return;else if (mbNotErase) {mbToBeErased = true;return;}}

?// step2. 從共視關鍵幀的共視圖中刪除本關鍵幀for (auto mit : mConnectedKeyFrameWeights)mit.first->EraseConnection(this);

?// step3. 刪除當前關鍵幀中地圖點對本幀的觀測for (size_t i = 0; i < mvpMapPoints.size(); i++)if (mvpMapPoints[i])mvpMapPoints[i]->EraseObservation(this);

?{// step4. 刪除共視圖unique_lock<mutex> lock(mMutexConnections);unique_lock<mutex> lock1(mMutexFeatures);mConnectedKeyFrameWeights.clear();mvpOrderedConnectedKeyFrames.clear();

?// step5. 更新生成樹結構set<KeyFrame *> sParentCandidates;sParentCandidates.insert(mpParent);

?while (!mspChildrens.empty()) {bool bContinue = false;int max = -1;KeyFrame *pC;KeyFrame *pP;for (KeyFrame *pKF : mspChildrens) {if (pKF->isBad())continue;

?vector<KeyFrame *> vpConnected = pKF->GetVectorCovisibleKeyFrames();

?for (size_t i = 0, iend = vpConnected.size(); i < iend; i++) {for (set<KeyFrame *>::iterator spcit = sParentCandidates.begin(), spcend = sParentCandidates.end();spcit != spcend; spcit++) {if (vpConnected[i]->mnId == (*spcit)->mnId) {int w = pKF->GetWeight(vpConnected[i]);if (w > max) {pC = pKF; pP = vpConnected[i]; max = w; bContinue = true; }}}}}

?if (bContinue) {pC->ChangeParent(pP);sParentCandidates.insert(pC);mspChildrens.erase(pC);} elsebreak;}

?if (!mspChildrens.empty())for (set<KeyFrame *>::iterator sit = mspChildrens.begin(); sit != mspChildrens.end(); sit++) {(*sit)->ChangeParent(mpParent);}

?mpParent->EraseChild(this);mTcp = Tcw * mpParent->GetPoseInverse();// step6. 將當前關鍵幀的 mbBad 置為 truembBad = true;} // step7. 從地圖中刪除當前關鍵幀mpMap->EraseKeyFrame(this);mpKeyFrameDB->erase(this);

}

5.6 對地圖點的觀測

KeyFrame類除了像一般的Frame類那樣保存二維圖像特征點以外,還保存三維地圖點MapPoint信息.

關鍵幀觀測到的地圖點列表由成員變量mvpMapPoints保存,下面是一些對該成員變量進行增刪改查的成員函數,就是簡單的列表操作,沒什么值得說的地方.

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

std::vector mvpMapPoints | protected | 當前關鍵幀觀測到的地圖點列表 |

void AddMapPoint(MapPoint* pMP, const size_t &idx) | public | |

void EraseMapPointMatch(const size_t &idx) | public | |

void EraseMapPointMatch(MapPoint* pMP) | public | |

void ReplaceMapPointMatch(const size_t &idx, MapPoint* pMP) | public | |

std::set GetMapPoints() | public | |

std::vector GetMapPointMatches() | public | |

int TrackedMapPoints(const int &minObs) | public | |

MapPoint* GetMapPoint(const size_t &idx) | public |

?值得關心的是上述函數的調用時機,也就是說參考幀何時與地圖點發生關系:

關鍵幀增加對地圖點觀測的時機:

Tracking線程和LocalMapping線程創建新地圖點后,會馬上調用函數KeyFrame::AddMapPoint()添加當前關鍵幀對該地圖點的觀測.

LocalMapping線程處理完畢緩沖隊列內所有關鍵幀后會調用LocalMapping::SearchInNeighbors()融合當前關鍵幀和共視關鍵幀間的重復地圖點,其中調用函數ORBmatcher::Fuse()實現融合過程中會調用函數KeyFrame::AddMapPoint().

LoopClosing線程閉環矯正函數LoopClosing::CorrectLoop()將閉環關鍵幀與其匹配關鍵幀間的地圖進行融合,會調用函數KeyFrame::AddMapPoint().

關鍵幀替換和刪除對地圖點觀測的時機:

MapPoint刪除函數MapPoint::SetBadFlag()或替換函數MapPoint::Replace()會調用KeyFrame::EraseMapPointMatch()和KeyFrame::ReplaceMapPointMatch()刪除和替換關鍵針對地圖點的觀測.

LocalMapping線程調用進行局部BA優化的函數Optimizer::LocalBundleAdjustment()內部調用函數KeyFrame::EraseMapPointMatch()刪除對重投影誤差較大的地圖點的觀測.

5.7 回環檢測與本質圖

| 成員函數/變量 | 訪問控制 | 意義 |

|---|---|---|

std::set mspLoopEdge | protected | 和當前幀形成回環的關鍵幀集合 |

set GetLoopEdges() | public | mspLoopEdge的get函數 |

void AddLoopEdge(KeyFrame *pKF) | public | mspLoopEdge的set函數 |

LoopClosing線程中回環矯正函數LoopClosing::CorrectLoop()在調用本質圖BA優化函數Optimizer::OptimizeEssentialGraph()之前會調用函數KeyFrame::AddLoopEdge(),在當前關鍵幀和其閉環匹配關鍵幀間添加回環關系.

在調用本質圖BA優化函數Optimizer::OptimizeEssentialGraph()中會調用函數KeyFrame::GetLoopEdges()將所有閉環關系加入到本質圖中進行優化.

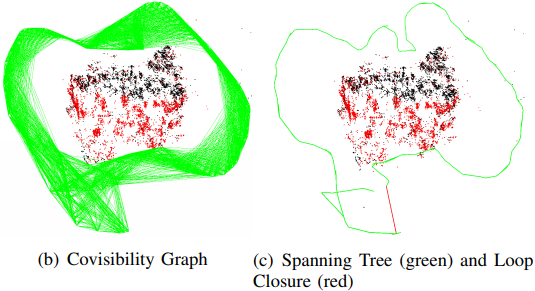

共視圖比較稠密,本質圖比共視圖更稀疏,這是因為本質圖的作用是用在閉環矯正時,用相似變換來矯

正尺度漂移,把閉環誤差均攤在本質圖中。本質圖中節點也是所有關鍵幀,但是連接邊更少,只保留了

聯系緊密的邊來使得結果更精確。本質圖中包含:

1. 擴展樹連接關系

2. 形成閉環的連接關系,閉環后地圖點變動后新增加的連接關系

3. 共視關系非常好(至少100個共視地圖點)的連接關系

void Optimizer::OptimizeEssentialGraph(Map* pMap, KeyFrame* pLoopKF, KeyFrame* pCurKF,const LoopClosing::KeyFrameAndPose &NonCorrectedSim3,const LoopClosing::KeyFrameAndPose &CorrectedSim3,const map<KeyFrame *, set<KeyFrame *> > &LoopConnections, const bool &bFixScale)